https://newsletter.languagemodels.co/p/the-illustrated-gpt-oss 번역글 입니다.

OpenAI의 GPT-OSS 공개는 6년 전 GPT-2 이후로 주요 오픈소스 LLM 공개입니다. 이 기간 동안 LLM의 성능은 급속히 발전했습니다. 그러나 이 모델 자체는 DeepSeek, Qwen, Kimi 등 기존 오픈소스 모델과 비교해 성능 면에서 획기적인 개선을 보여주지는 않습니다. 그럼에도 불구하고, 이 모델은 이 기간 동안 LLM이 어떻게 변화했는지 재검토하는 좋은 기회를 제공합니다.

이전 오픈소스 GPT 모델과의 차이점

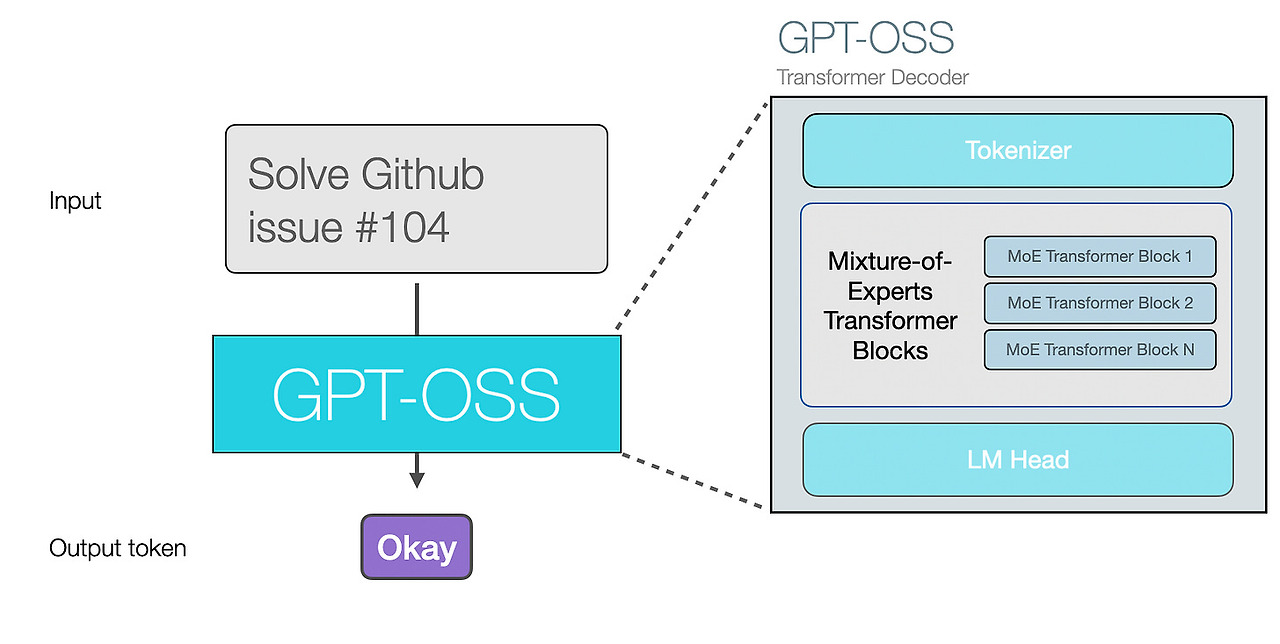

GPT-OSS는 이전 모델들과 마찬가지로 자동 회귀형 트랜스포머(autoregressive Transformer)로, 한 번에 하나의 토큰을 생성합니다.

2025년 중반에 출시될 대규모 언어 모델(LLM)의 주요 차이점은 생성하는 토큰이 다음과 같은 방식으로 훨씬 더 어려운 문제를 해결할 수 있다는 점입니다.

- 도구 활용

- 추론

- 문제 해결 및 코딩 능력 향상

다음 그림에서 볼 수 있듯이, 주요 아키텍처 특징은 현재 사용 가능한 오픈소스 모델과 크게 다르지 않습니다. GPT-2와의 주요 아키텍처 차이는 GPT-OSS가 전문가 혼합 모델(mixture-of-experts model)이라는 점입니다.

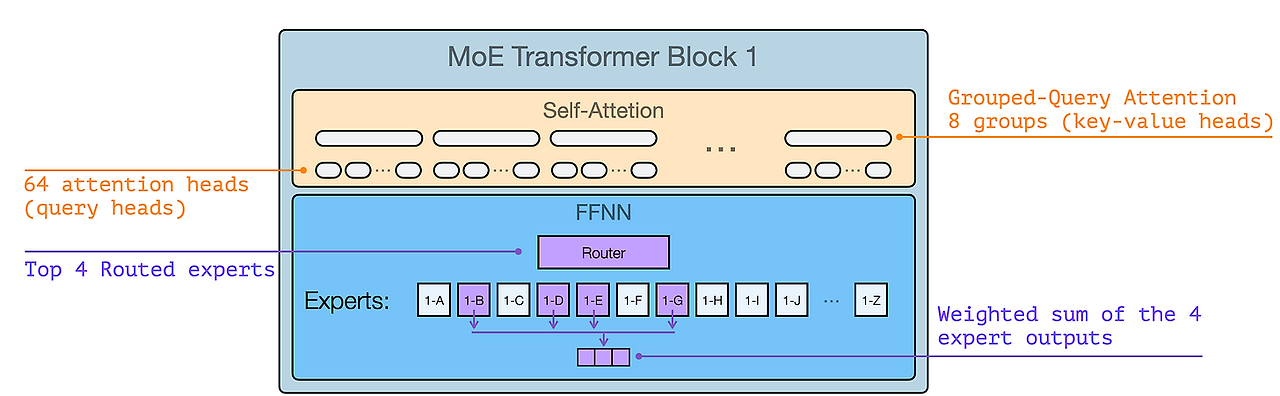

GPT-OSS Transformer Block은 다음 그림과 같습니다.

참고로, 이러한 아키텍쳐 세부 사항 중 대부분은 특별히 새로운 것이 아닙니다. 이들은 최신 SoTA 오픈소스 MoE 모델에서 일반적으로 유사합니다.

메시지 형식

많은 사용자에게는 모델의 추론 과정과 도구 호출의 세부적인 동작 및 형식이 아키텍처보다 더 중요합니다.

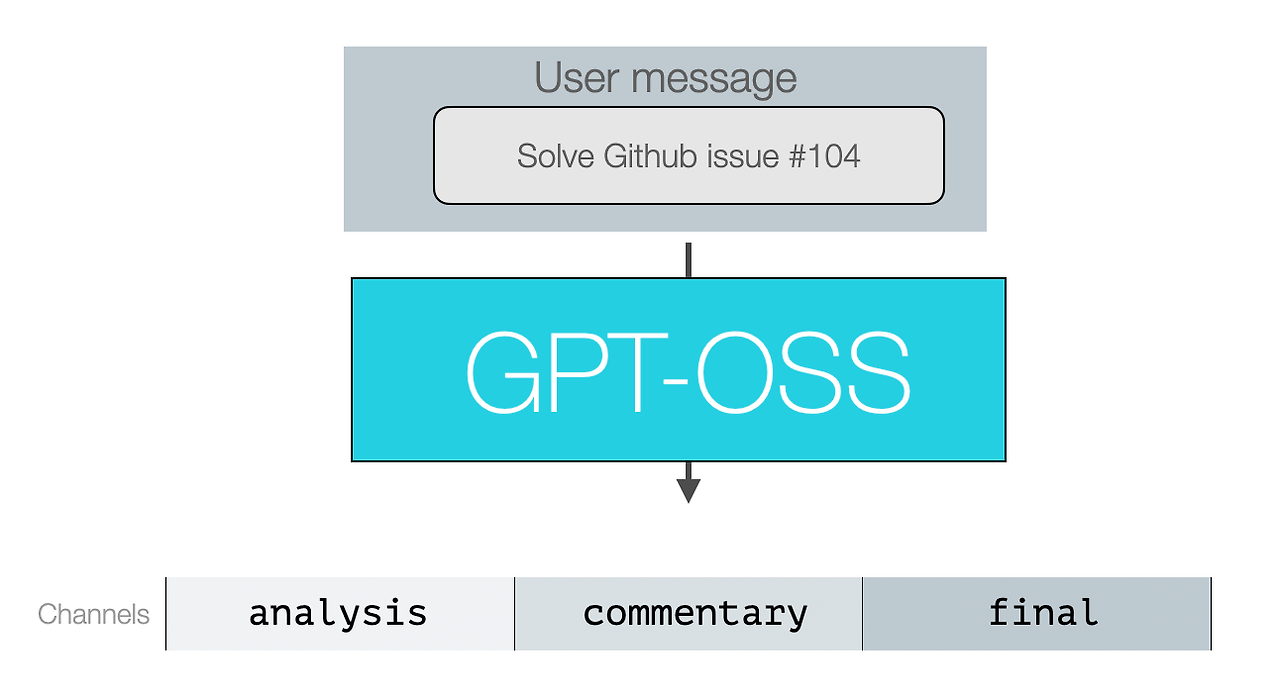

다음 그림에서 모델의 입력과 출력의 형태를 확인할 수 있습니다.

이 내용을 세 가지 주요 유형의 오픈소스 LLM 사용자로 나누어 살펴보겠습니다:

- LLM 앱의 최종 사용자

- 예시: ChatGPT 앱 사용자

- 이 사용자들은 주로 자신이 전송한 사용자 메시지와 최종 답변을 상호작용합니다. 일부 앱에서는 중간 추론 기록의 일부를 볼 수 있습니다.

- LLM 앱 개발자

- 예시: Cursor 또는 Manus

- 입력 메시지: 이 개발자들은 시스템 및 개발자 메시지를 직접 설정합니다. 이는 모델이 기대하는 일반적인 행동, 안전성 선택 사항, 추론 수준, 모델이 사용할 도구 정의 등을 포함합니다. 또한 사용자 메시지에서 프롬프트 엔지니어링과 컨텍스트 관리를 많이 수행해야 합니다.

- 출력 메시지: 개발자는 사용자에게 추론 추적을 표시할지 여부를 선택할 수 있습니다. 또한 추론 수준을 정의하고 도구를 설정합니다.

- LLM 후처리자

- 모델을 미세 조정하는 파워 사용자는 모든 메시지 유형과 형식을 올바르게 형식화하여 추론 및 도구 호출 및 응답을 포함해 데이터를 처리해야 합니다.

후자 두 카테고리(LLM 앱 빌더와 LLM 포스트 트레이너)는 어시스턴트 메시지의 채널 개념을 이해하는 데 이점을 얻습니다. 이는 OpenAI Harmony 리포지토리에 구현되어 있습니다.

(이 유형의 설명이 도움이 된다면, 이 수준에서 LLMs를 설명하는 300개 이상의 그림이 포함된 베스트셀러 책과 현재 14,000개 별점을 받은 GitHub 리포지토리를 확인해 보세요)

메시지 채널

모델 출력은 모두 보조 메시지입니다. 모델은 메시지의 유형을 표시하기 위해 이를 '채널' 카테고리에 할당합니다.

- 추론 분석 (및 일부 도구 호출)

- 기능 호출에 대한 설명 (및 대부분의 도구 호출)

- 최종 메시지 (최종 응답 포함)

따라서 모델에 추론이 필요하고 몇 가지 도구 호출을 사용해야 하는 프롬프트를 제공한다고 가정할 때, 다음 그림은 세 가지 메시지 유형이 모두 사용된 대화를 보여줍니다.

이들은 1, 3, 5번 단계로 표시됩니다. 2번과 4번 단계는 해당 호출에 대한 도구 응답이기 때문입니다. 최종 답변은 최종 사용자가 볼 수 있는 내용입니다.

Reasoning

추론에는 고급 사용자가 선택해야 하는 타협점이 있습니다. 한쪽으로는 더 많은 추론이 모델이 문제에 대해 더 많은 시간과 컴퓨팅 자원을 할당해 추론할 수 있게 해줘서 더 어려운 문제를 해결하는 데 도움이 됩니다. 반면, 이는 지연 시간과 컴퓨팅 자원의 비용을 초래합니다. 이 선택은 강력한 추론 능력을 갖춘 LLM과 추론을 하지 않는 LLM이 각각 다른 종류의 문제를 해결하는 데 가장 적합한 것으로 나타납니다.

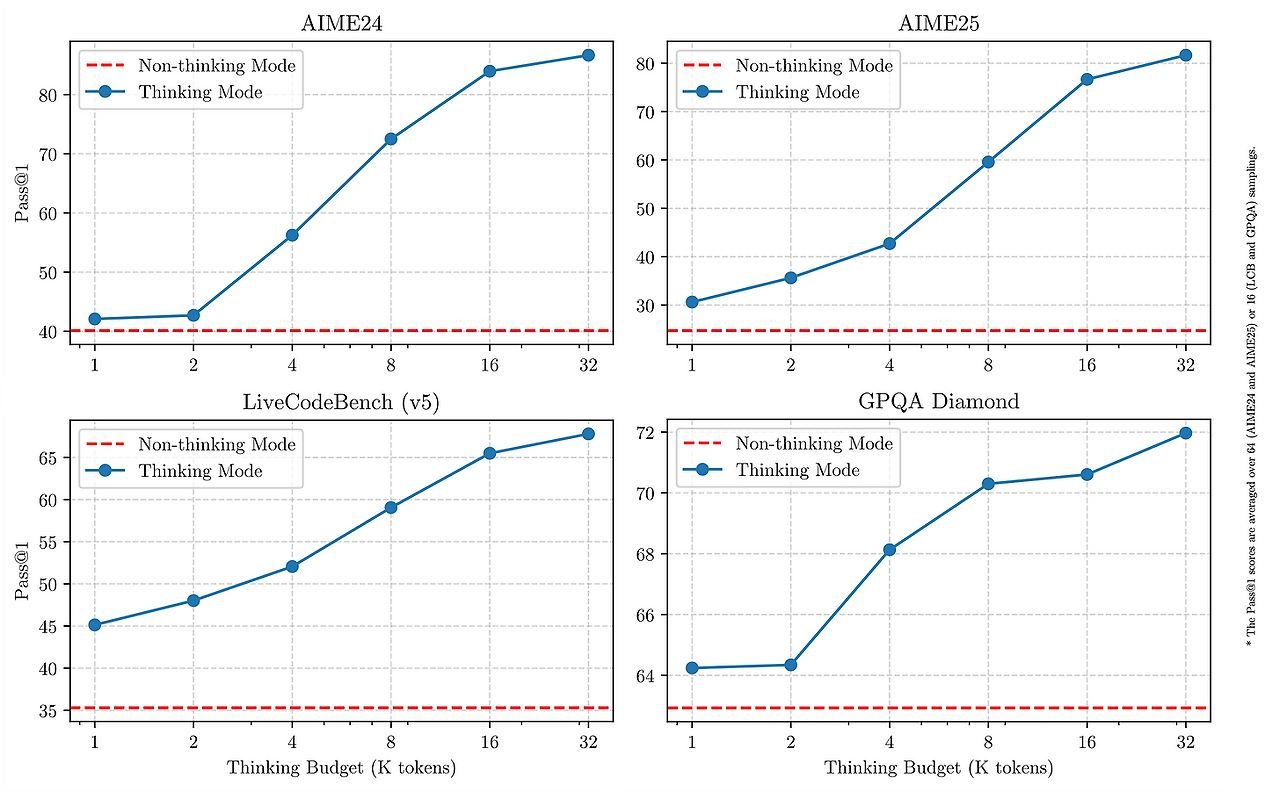

중간 옵션으로는 특정 추론 예산에 따라 응답하는 추론 모델을 사용하는 것입니다. 이는 GPT-OSS가 속한 카테고리입니다. 이 모델은 시스템 메시지를 통해 추론 모드(낮음, 중간, 높음)를 설정할 수 있습니다. 모델 카드의 그림 3은 이 설정이 벤치마크 점수에 미치는 영향과 추론 추적(체인-오브-씽크 또는 CoT)에 포함된 토큰 수를 보여줍니다.

이것은 Qwen3의 추론 모드와 대비할 수 있습니다. Qwen3의 추론 모드는 이분법적 사고 모드와 비사고 모드로 구분됩니다. 사고 모드에서는 특정 토큰 임계값을 초과하면 사고를 중단하는 방법을 보여주며, 이가 다양한 추론 벤치마크의 점수에 미치는 영향을 보고합니다.

Reasoning Modes (low, medium, and high)

추론 모드 간의 차이를 보여주는 좋은 방법은 어려운 추론 문제를 제시하는 것입니다. 따라서 AIME25 데이터셋에서 한 문제를 선택하고 120B 모델에 세 가지 추론 모드로 질문을 던져보았습니다.

이 질문의 정답은 104입니다. 따라서 중간 및 고급 추론 모드 모두 정답을 맞췄습니다. 그러나 고급 추론 모드는 해당 답에 도달하기 위해 계산/생성 시간이 두 배가 소요됩니다.

이는 앞서 언급한 내용과 일치하며, 사용 사례에 맞는 적절한 추론 모드를 선택하는 것이 중요함을 강조합니다.

- 대리적 작업을 수행하고 있나요? 경로가 많은 단계로 구성될 경우, 높은 수준의 추론이나 중간 수준의 추론조차도 시간이 너무 오래 걸릴 수 있습니다.

- 실시간 vs. 오프라인 - 사용자가 목표 달성을 위해 적극적으로 기다리지 않는 상황에서 수행될 수 있는 작업을 고려하세요

- 여기서 고려할 예시는 검색 엔진입니다 — 쿼리 시간에 매우 빠른 결과를 얻을 수 있는 이유는 시스템이 해당 경험을 위해 이미 많은 처리와 설계가 이루어졌기 때문입니다.

Tokenizer

토크나이저는 GPT-4의 것과 상당히 유사하지만, 특히 비영어 토큰 처리에서 약간 더 효율적이라고 느껴집니다. 이모티콘과 중국 문자가 각각 3개가 아닌 2개의 토큰으로 분할되는 점, 아랍어 텍스트의 더 많은 부분이 개별 토큰으로 그룹화되는 대신 문자로 분할되지 않는 점을 주목해 주세요.

그러나 토크나이저가 이 부분에서 더 우수할 수 있지만, 모델은 주로 영어 데이터로 훈련되었습니다.

코드(파이썬 코드에서 들여쓰기를 위해 사용되는 탭 포함)는 주로 동일한 방식으로 작동하는 것으로 보입니다. 숫자 토큰화도 동일한 방식으로 작동하는 것으로 보이며, 3자리 숫자까지 개별 토큰으로 할당하고 더 큰 토큰은 분할합니다.

'AI-ML > LLM' 카테고리의 다른 글

| LLM 평가의 4가지 주요 접근법 이해하기 (0) | 2025.10.06 |

|---|---|

| 논문 읽어보기 - Learning to Reason as Action Abstractions with Scalable Mid-Training RL (0) | 2025.10.05 |

| LLM에서 Self-Attention, Multi-Head Attention, Causal-Attention, 및 Cross-Attention의 이해와 Code 해석 (6) | 2025.08.11 |

| GPT-2에서 gpt-oss로: 아키텍처적 개선점 분석 (4) | 2025.08.10 |

| 추론 능력(Reasoning) 이해를 위한 대규모 언어 모델(LLMs) (3) | 2025.07.22 |