추론 모델의 구축 및 개선을 위한 방법과 전략

https://magazine.sebastianraschka.com/p/understanding-reasoning-llms 글 번역했습니다.

이 글은 추론 모델을 구축하는 네 가지 주요 접근 방식, 즉 LLMs에 추론 능력을 강화하는 방법을 설명합니다. 이 내용이 유용한 통찰을 제공하며, 이 주제를 둘러싼 빠르게 변화하는 연구 동향과 과대 광고를 이해하는 데 도움이 되길 바랍니다.

2024년에는 LLM 분야에서 전문성이 더욱 강화되었습니다. 사전 훈련과 미세 조정 beyond, RAG부터 코드 어시스턴트에 이르는 전문적인 응용 사례들이 등장했습니다. 2025년에는 이 트렌드가 가속화될 것으로 예상되며, 특히 도메인 및 응용 분야별 최적화(즉, "전문성")에 더욱 중점이 두어질 것입니다.

추론 모델의 개발은 이러한 전문 분야 중 하나입니다. 이는 LLMs를 중간 단계가 필요한 복잡한 작업, 예를 들어 퍼즐, 고급 수학, 코딩 과제 등에 최적화되도록 개선하는 것을 의미합니다. 그러나 이 전문 분야는 다른 LLM 응용 분야를 대체하지 않습니다. 왜냐하면 LLM을 추론 모델로 변환하는 과정에서도 특정 단점이 발생하기 때문입니다. 이 단점들은 나중에 논의할 것입니다.

아래에서 다룰 내용을 간략히 소개하자면, 이 기사에서는 다음과 같은 내용을 다룰 것입니다:

- 추론 모델의 의미를 설명합니다

- 추론 모델의 장점과 단점을 논의합니다

- DeepSeek R1의 방법론을 개요합니다

- 추론 모델을 구축하고 개선하는 네 가지 주요 접근 방식을 설명합니다

- DeepSeek V3 및 R1 출시 이후 LLM 생태계에 대한 생각을 공유합니다

- 제한된 예산으로 추론 모델을 개발하는 팁을 제공합니다

올해 AI가 빠르게 발전하는 가운데 이 기사가 유용하길 바랍니다!

"추론 모델"을 어떻게 정의할 수 있을까요?

인공지능(AI) 또는 기계학습 분야에서 일한다면, 모호하고 논쟁의 여지가 많은 정의들에 익숙할 것입니다. "추론 모델"이라는 용어도 예외는 아닙니다. 결국 누군가가 논문에서 이를 공식적으로 정의하겠지만, 다음 논문에서는 다시 정의될 것이며, 이 과정은 반복될 것입니다.

이 글에서는 "추론"을 복잡하고 다단계의 중간 단계를 거쳐 질문에 답변하는 과정으로 정의합니다. 예를 들어, "프랑스의 수도는 무엇인가?"와 같은 사실 기반 질문 답변은 추론을 포함하지 않습니다. 반면, "시속 60마일로 움직이는 기차가 3시간 동안 이동하면 얼마나 멀리 가나요?"와 같은 질문은 간단한 추론을 요구합니다. 예를 들어, 답에 도달하기 전에 거리, 속도, 시간 간의 관계를 인식해야 합니다.

대부분의 현대적 대규모 언어 모델(LLM)은 기본적인 추론 능력을 갖추고 있으며, "시속 60마일로 움직이는 기차가 3시간 동안 이동하면 얼마나 멀리 갈까요?"와 같은 질문에 답변할 수 있습니다. 따라서 오늘날 추론 모델을 언급할 때, 우리는 일반적으로 퍼즐, 수수께끼, 수학적 증명과 같은 더 복잡한 추론 작업에 뛰어난 성능을 보이는 LLM을 의미합니다.

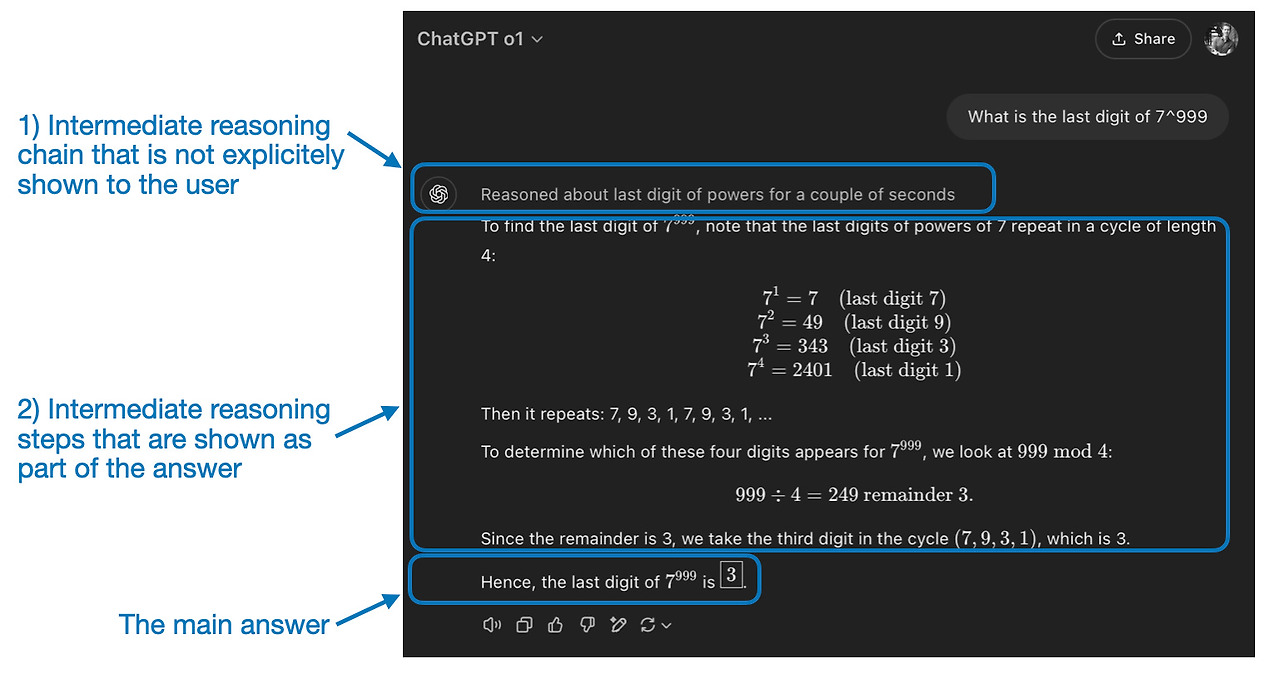

또한 현재 추론 모델로 분류되는 대부분의 LLMs는 응답의 일부로 "생각" 또는 "추론" 과정을 포함합니다. LLMs가 실제로 어떻게 "생각"하는지는 별도의 논의 주제입니다.

추론 모델의 중간 단계는 두 가지 방식으로 나타날 수 있습니다. 첫째, 이전 그림에서 보여진 것처럼 응답에 명시적으로 포함될 수 있습니다. 둘째, OpenAI의 o1과 같은 일부 추론 LLMs는 사용자에게 표시되지 않는 중간 단계를 포함해 여러 번의 반복을 수행합니다.

추론 모델은 언제 사용해야 하나요?

이제 추론 모델을 정의했으니, 이제 더 흥미로운 부분으로 넘어가겠습니다: 추론 작업을 위해 LLMs를 구축하고 개선하는 방법입니다. 그러나 기술적 세부 사항에 뛰어들기 전에, 추론 모델이 실제로 필요한 시점을 고려하는 것이 중요합니다.

추론 모델은 언제 필요할까요? 추론 모델은 퍼즐 해결, 고급 수학 문제, 어려운 코딩 작업과 같은 복잡한 작업에 우수하도록 설계되었습니다. 그러나 요약, 번역, 지식 기반 질문 답변과 같은 단순한 작업에는 필요하지 않습니다. 실제로 모든 작업에 추론 모델을 사용하는 것은 비효율적이고 비용이 많이 들 수 있습니다. 예를 들어, 추론 모델은 일반적으로 사용 비용이 더 높고, 설명이 길며, "과도한 추론"으로 인해 오류가 발생하기 쉽습니다. 여기에서도 간단한 원칙이 적용됩니다: 작업에 맞는 도구(또는 LLM 유형)를 사용하세요.

추론 모델의 주요 강점과 한계는 아래 그림에 요약되어 있습니다.

DeepSeek 훈련 파이프라인의 간략한 개요

다음 섹션에서 추론 모델을 구축하고 개선하는 네 가지 주요 접근 방식을 논의하기 전에, DeepSeek R1 기술 보고서에서 설명된 DeepSeek R1 파이프라인을 간략히 소개하고자 합니다. 이 보고서는 흥미로운 사례 연구이자 추론 LLMs 개발을 위한 청사진 역할을 합니다.

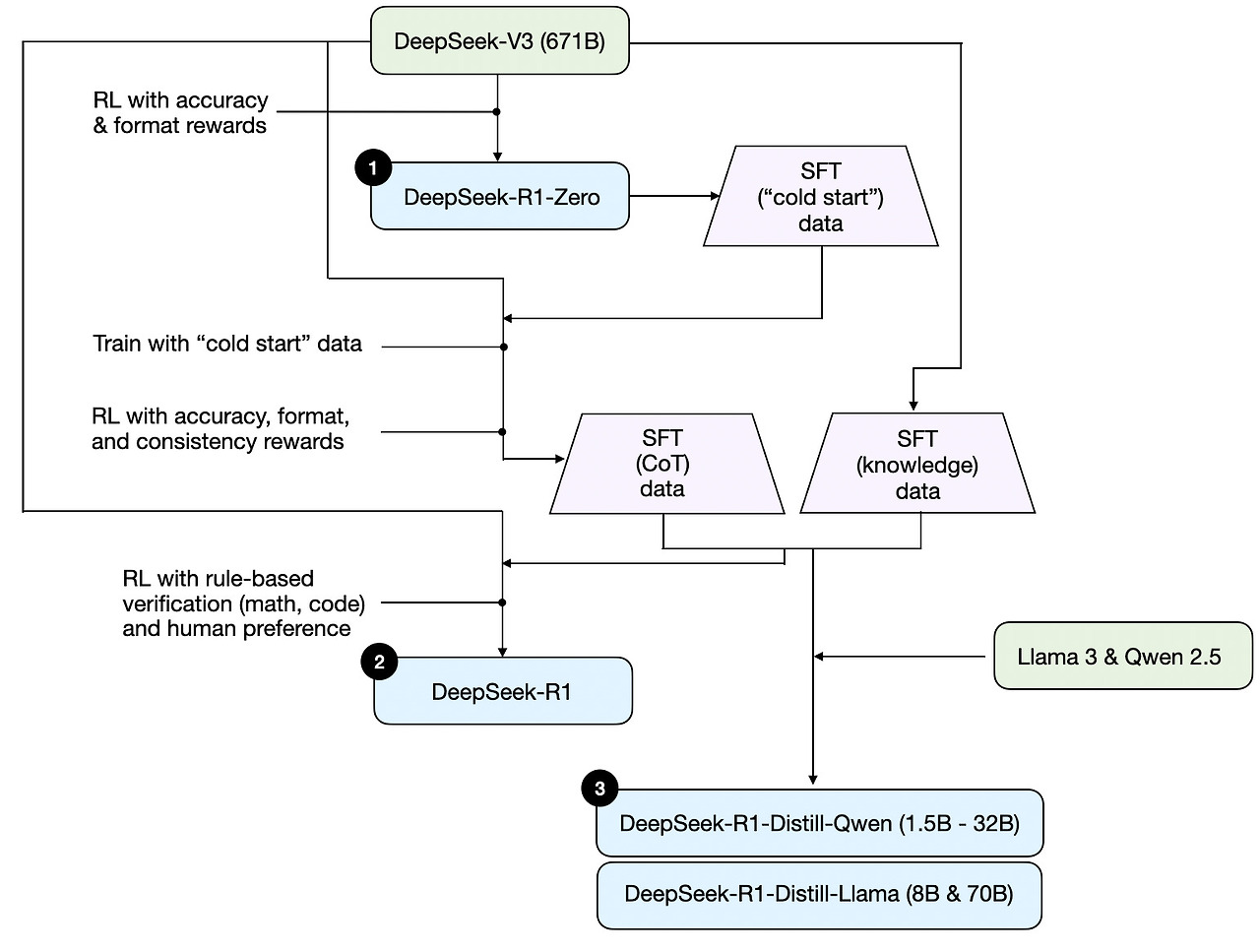

참고로 DeepSeek는 단일 R1 추론 모델을 공개하지 않았으며, 대신 세 가지 서로 다른 변형 모델을 소개했습니다: DeepSeek-R1-Zero, DeepSeek-R1, 및 DeepSeek-R1-Distill.

기술 보고서에 설명된 내용을 바탕으로, 이 모델들의 개발 과정을 아래 다이어그램에 요약했습니다.

다음으로, 위 다이어그램에 표시된 프로세스를 간단히 살펴보겠습니다. 자세한 내용은 다음 섹션에서 설명할 예정이며, 해당 섹션에서는 추론 모델을 구축하고 개선하는 네 가지 주요 접근 방식에 대해 논의할 것입니다.

(1) DeepSeek-R1-Zero: 이 모델은 2024년 12월에 공개된 671B 사전 훈련된 DeepSeek-V3 기본 모델을 기반으로 합니다. 연구팀은 두 가지 유형의 보상을 사용한 강화 학습(RL)을 통해 이 모델을 훈련했습니다. 이 접근 방식은 인간 피드백을 포함한 강화 학습(RLHF)의 일반적인 단계인 감독형 미세 조정(SFT) 단계를 포함하지 않았기 때문에 "콜드 스타트" 훈련으로 불립니다.

(2) DeepSeek-R1: 이 모델은 DeepSeek의 플래그십 추론 모델로, DeepSeek-R1-Zero를 기반으로 구축되었습니다. 연구팀은 추가적인 SFT 단계와 RL 훈련을 통해 "콜드 스타트" R1-Zero 모델을 개선했습니다.

(3) DeepSeek-R1-Distill*: 이전 단계에서 생성된 SFT 데이터를 활용해 DeepSeek 팀은 Qwen 및 Llama 모델을 미세 조정하여 추론 능력을 향상시켰습니다. 전통적인 의미의 디스틸레이션은 아니지만, 이 과정은 더 작은 모델(Llama 8B 및 70B, Qwen 1.5B–30B)을 더 큰 DeepSeek-R1 671B 모델의 출력에 대해 훈련하는 방식으로 진행되었습니다.

추론 모델을 구축하고 개선하는 4가지 주요 방법

이 섹션에서는 LLMs의 추론 능력을 향상시키기 위해 현재 사용 중인 주요 기술과 DeepSeek-R1, OpenAI의 o1 및 o3와 같은 전문 추론 모델을 구축하는 방법을 개요로 설명합니다.

참고: o1과 o3의 정확한 작동 원리는 OpenAI 외부에서는 아직 알려지지 않았습니다. 그러나 이들은 추론 기술과 훈련 기술의 조합을 활용한다는 소문이 있습니다.

1) 추론 시간 확장성

LLM의 추론 능력(또는 일반적인 어떤 능력)을 향상시키는 한 가지 방법은 추론 시점 확장(inference-time scaling)입니다. 이 용어는 다양한 의미를 가질 수 있지만, 이 맥락에서는 추론 과정에서 계산 자원을 증가시켜 출력 품질을 개선하는 것을 의미합니다.

대략적인 비유로, 인간은 복잡한 문제를 해결할 때 더 많은 시간을 할애할수록 더 나은 답변을 생성하는 경향이 있습니다. 同様に, LLM이 답변을 생성하는 과정에서 "더 많이 생각하도록" 유도하는 기술을 적용할 수 있습니다. (그러나 LLM이 실제로 "생각한다"는 것은 다른 논의 주제입니다.)

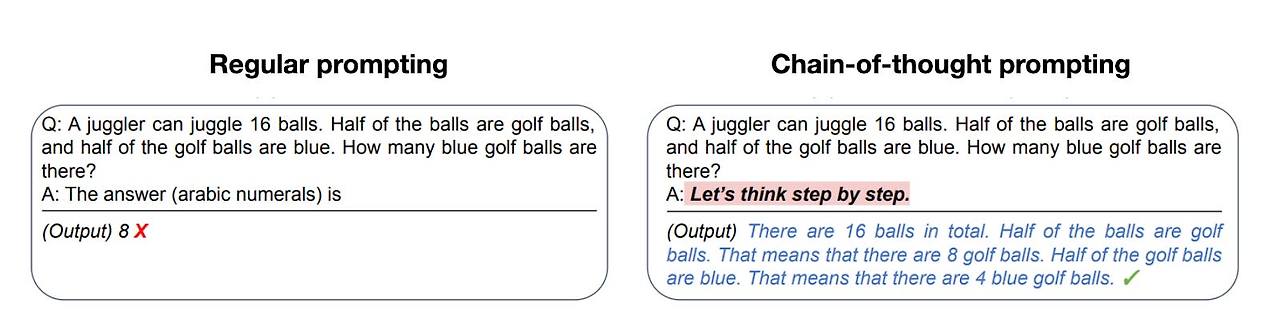

추론 시간 확장(inference-time scaling)의 간단한 접근 방식 중 하나는 현명한 프롬프트 엔지니어링입니다. 대표적인 예로는 "단계별로 생각하라"와 같은 문구를 입력 프롬프트에 포함하는 체인-오브-씽크(CoT) 프롬프트링이 있습니다. 이 방법은 모델이 최종 답변으로 바로 뛰어드는 대신 중간 추론 단계를 생성하도록 장려합니다. 이는 복잡한 문제에서 종종(하지만 항상은 아니지만) 더 정확한 결과를 이끌어낼 수 있습니다. (참고로, "프랑스의 수도는 무엇인가"와 같은 단순한 지식 기반 질문에는 이 전략을 적용하는 것이 의미가 없습니다. 이는 주어진 입력 쿼리에 대해 추론 모델이 적절한지 판단하는 좋은 지침이 됩니다.)

앞서 언급된 CoT 접근 방식은 출력 토큰을 더 많이 생성함으로써 추론 비용을 증가시키기 때문에 추론 시간 확장(inference-time scaling)으로 볼 수 있습니다.

추론 시간 확장의 또 다른 접근 방식은 투표 및 검색 전략의 사용입니다. 간단한 예로 다수결 투표가 있으며, 이 경우 LLM이 여러 개의 답변을 생성하고 다수결로 정답을 선택합니다. 마찬가지로 빔 검색(beam search) 및 기타 검색 알고리즘을 사용하여 더 나은 응답을 생성할 수 있습니다.

저는 이전에 작성한 2024년 주목할 만한 AI 연구 논문(Part Two) 기사(https://magazine.sebastianraschka.com/p/ai-researc)에서 설명한 "Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters" 논문을 강력히 추천합니다.

DeepSeek R1 기술 보고서는 일반적인 추론 시간 확장 방법(예: 프로세스 보상 모델 기반 및 몬테 카를로 트리 검색 기반 접근 방식)을 "실패한 시도"로 분류합니다. 이는 DeepSeek가 R1 모델의 자연스러운 경향인 더 긴 응답을 생성하는 것 외에 이러한 기술을 명시적으로 사용하지 않았음을 시사합니다. 이 경향은 V3 기본 모델과 비교할 때 추론 시간 확장의 암시적 형태로 작용합니다.

그러나 추론 시간 스케일링은 일반적으로 LLM 자체보다는 애플리케이션 레이어에서 구현되므로, DeepSeek는 여전히 앱 내에서 이러한 기술을 적용할 수 있습니다.

OpenAI의 o1 및 o3 모델은 추론 시간 스케일링을 사용한다고 추정되며, 이는 GPT-4o와 비교해 상대적으로 비용이 높은 이유를 설명할 수 있습니다. 추론 시간 스케일링 외에도 o1 및 o3는 DeepSeek R1과 유사한 강화 학습 파이프라인을 사용하여 훈련되었을 가능성이 높습니다. 강화 학습에 대한 자세한 내용은 아래 두 섹션에서 설명됩니다.

2) 순수 강화 학습 (RL)

DeepSeek R1 논문에서 제가 개인적으로 가장 인상 깊게 느낀 점 중 하나는 순수한 강화 학습(RL)에서 추론이 행동으로 나타난다는 그들의 발견입니다. 이 의미에 대해 더 자세히 살펴보겠습니다.

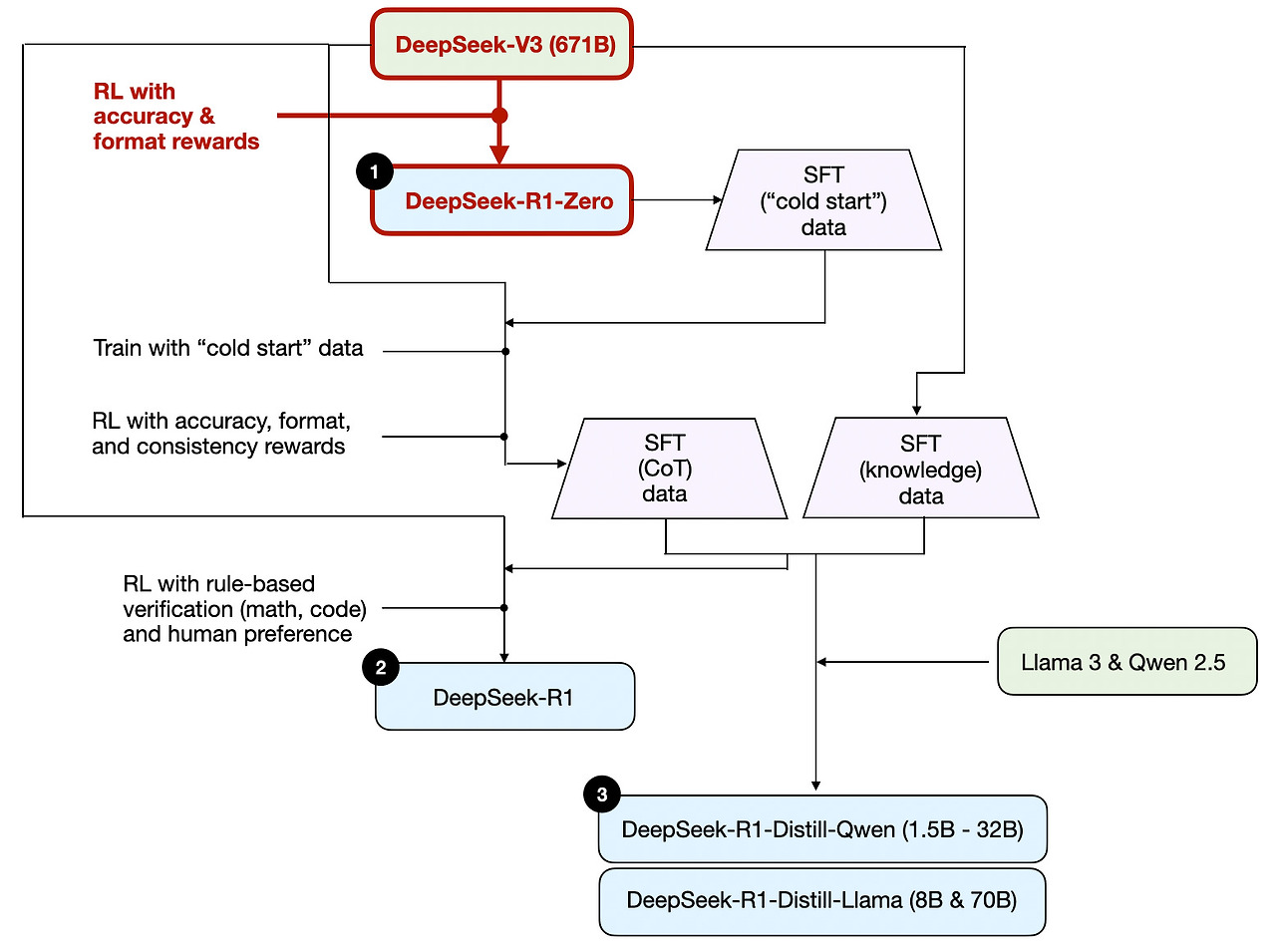

앞서 설명한 대로, DeepSeek은 세 가지 유형의 R1 모델을 개발했습니다. 첫 번째 모델인 DeepSeek-R1-Zero는 2024년 12월에 공개된 표준 사전 훈련된 LLM인 DeepSeek-V3 기반 모델을 기반으로 구축되었습니다. 일반적인 RL 파이프라인과 달리, DeepSeek-R1-Zero는 강화 학습만으로 훈련되었으며, 초기 SFT 단계 없이 직접 강화 학습을 적용했습니다. 이는 아래 다이어그램에서 강조된 바와 같습니다.

그러나 이 RL 과정은 일반적으로 선호도 조정(preference-tune)을 위한 LLMs에 적용되는 RLHF 접근 방식과 유사합니다. (RLHF에 대해 더 자세히 설명한 제 기사, "LLM Training: RLHF and Its Alternatives"를 참고하세요.) 그러나 위에서 언급된 것처럼 DeepSeek-R1-Zero의 핵심 차이점은 지시문 조정(instruction tuning) 단계에서 감독형 미세 조정(SFT) 단계를 생략했다는 점입니다. 이 때문에 이를 "순수한" RL이라고 부릅니다. (그러나 LLMs 맥락에서의 RL은 전통적인 RL과 크게 다르며, 이는 다른 주제로 다룰 내용입니다.)

보상으로는 인간 선호도에 따라 훈련된 보상 모델 대신 정확도 보상과 형식 보상 두 가지 유형의 보상을 사용했습니다.

- 정확도 보상은 LeetCode 컴파일러를 사용하여 코딩 답변을 검증하고, 수학적 응답을 평가하기 위해 결정론적 시스템을 사용합니다.

- 형식 보상은 LLM 판정 시스템을 통해 응답이 예상된 형식을 준수하는지 확인합니다. 예를 들어, 추론 단계를 <think> 태그 안에 넣는 것이 포함됩니다.

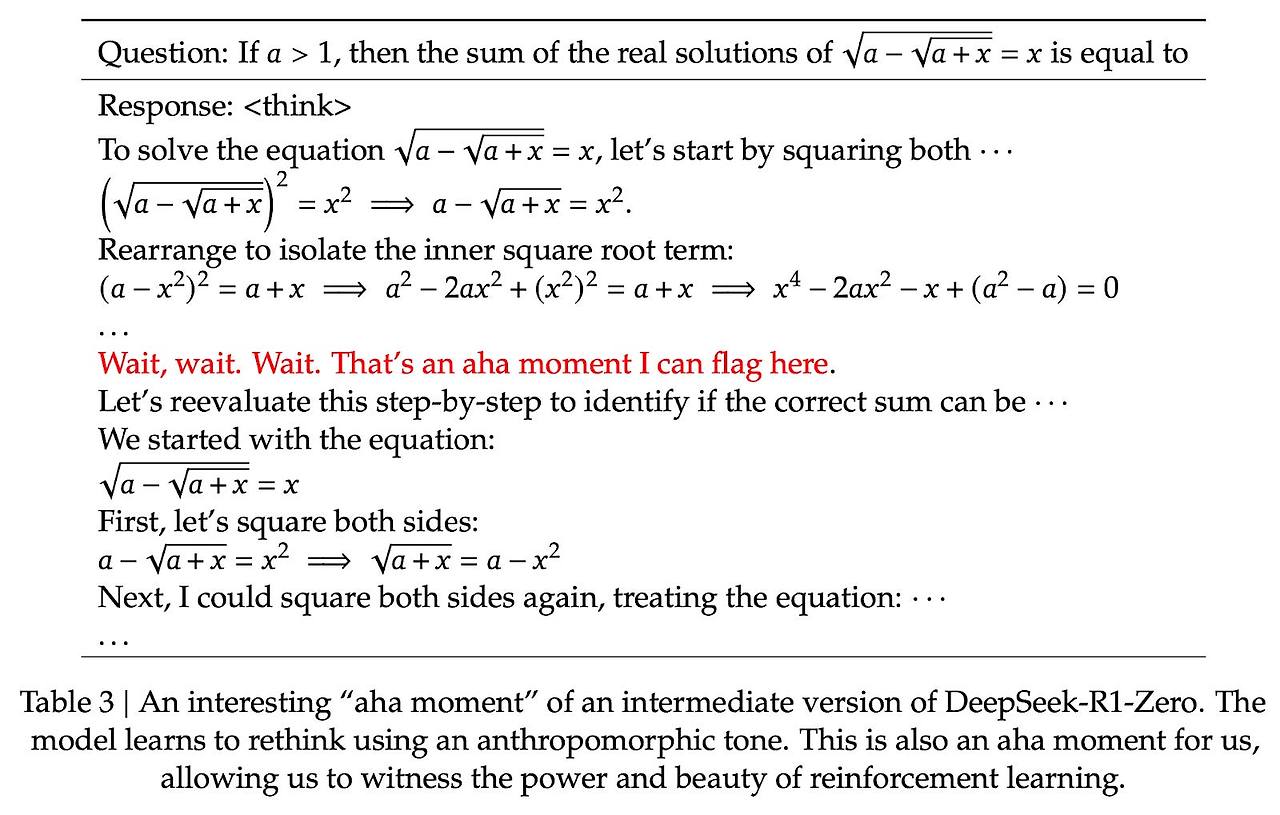

놀랍게도 이 접근 방식만으로도 LLM이 기본적인 추론 능력을 개발했습니다. 연구진은 모델이 명시적으로 훈련되지 않았음에도 불구하고 응답의 일부로 추론 과정을 생성하기 시작하는 "아하!" 순간을 관찰했습니다. 이는 아래 그림에 표시되어 있습니다.

R1-Zero는 최상위 성능의 추론 모델은 아니지만, 위 그림에서 보여지듯이 중간 단계의 "추론" 단계를 생성함으로써 추론 능력을 입증합니다. 이는 순수한 강화 학습(RL)을 사용하여 추론 모델을 개발할 수 있음을 확인하며, DeepSeek 팀이 이 접근 방식을 최초로 시연하거나(또는 적어도 발표) 한 팀입니다.

3) Supervised 미세조정 및 강화 학습 (SFT + RL)

다음으로, DeepSeek의 대표적 추론 모델인 DeepSeek-R1의 개발 과정을 살펴보겠습니다. 이 모델은 추론 모델을 구축하는 데 있어 기본 틀을 제공하는 역할을 합니다. 이 모델은 DeepSeek-R1-Zero를 기반으로 추가적인 감독형 미세 조정(SFT)과 강화 학습(RL)을 도입하여 추론 성능을 향상시켰습니다.

참고로, RL 전에 SFT 단계를 포함하는 것은 표준 RLHF 파이프라인에서 흔히 볼 수 있는 방식입니다. OpenAI의 o1도 유사한 접근 방식으로 개발되었을 가능성이 높습니다.

위 다이어그램에서 볼 수 있듯이, DeepSeek 팀은 DeepSeek-R1-Zero를 사용하여 "콜드 스타트" SFT 데이터를 생성했습니다. "콜드 스타트"라는 용어는 이 데이터가 감독형 미세 조정(SFT) 데이터로 훈련되지 않은 DeepSeek-R1-Zero 자체에 의해 생성되었음을 의미합니다.

이 콜드 스타트 SFT 데이터를 사용해 DeepSeek는 모델을 지시문 미세 조정(instruction fine-tuning)을 통해 훈련한 후, 추가로 강화 학습(RL) 단계를 진행했습니다. 이 RL 단계에서는 DeepSeek-R1-Zero의 RL 과정에서 사용된 정확도와 보상 형식을 동일하게 유지했습니다. 그러나 모델이 응답 내에서 여러 언어를 혼합하는 현상을 방지하기 위해 일관성 보상을 추가했습니다.

RL 단계 이후 또 다른 SFT 데이터 수집 단계가 진행되었습니다. 이 단계에서 가장 최근의 모델 체크포인트를 사용하여 600K개의 Chain-of-Thought (CoT) SFT 예제를 생성했으며, 추가로 DeepSeek-V3 기본 모델을 사용하여 200K개의 지식 기반 SFT 예제를 생성했습니다.

이 600K + 200K SFT 샘플은 DeepSeek-V3 기반 모델의 지시문 미세 조정(instruction-finetuning)에 사용되었으며, 이후 최종 RL 단계가 진행되었습니다. 이 단계에서는 수학 및 코딩 질문에 대해 정확도 보상을 위해 규칙 기반 방법을 다시 사용했으며, 다른 질문 유형에는 인간 선호도 라벨을 사용했습니다. 전체적으로 이는 일반적인 RLHF와 매우 유사하지만, SFT 데이터에 (더 많은) CoT 예제가 포함되어 있으며, RL에는 인간 선호도 기반 보상 외에도 검증 가능한 보상이 추가되었습니다.

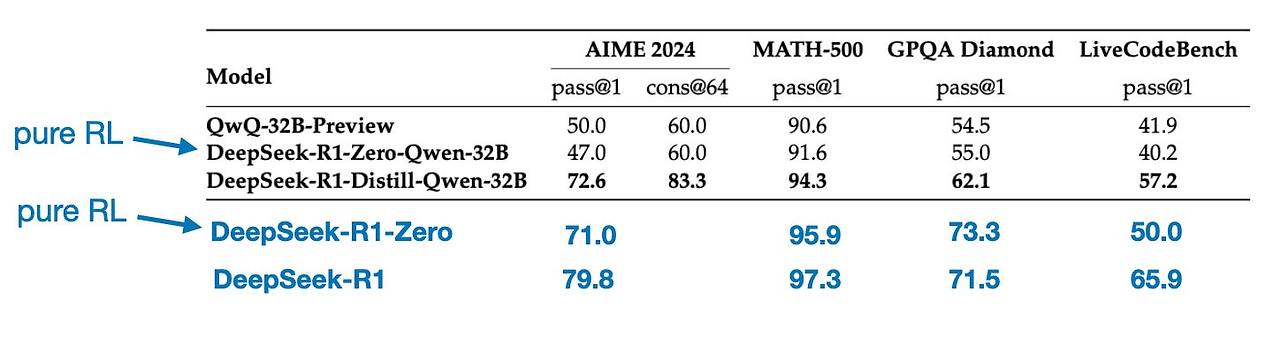

최종 모델인 DeepSeek-R1은 추가된 SFT 및 RL 단계 덕분에 DeepSeek-R1-Zero에 비해 눈에 띄는 성능 향상을 보였으며, 이는 아래 표에 표시되어 있습니다.

4) 순수 감독형 미세 조정(SFT) 및 증류

현재까지 우리는 추론 모델을 구축하고 개선하는 세 가지 주요 접근 방법을 살펴보았습니다:

- 추론 시 확장(Inference-time scaling): 기본 모델을 훈련하거나 수정하지 않고 추론 능력을 향상시키는 기술입니다.

- DeepSeek-R1-Zero에서 보여진 순수 강화 학습(RL)은 감독형 미세 조정이 없이 추론이 학습된 행동으로 나타날 수 있음을 보여주었습니다.

- 감독형 미세 조정(SFT)과 RL의 결합은 DeepSeek의 대표 추론 모델인 DeepSeek-R1을 이끌어냈습니다.

그럼 남은 것은 무엇일까요? 모델 'distillation(증류)'입니다.

놀랍게도 DeepSeek는 증류 과정을 통해 훈련된 더 작은 모델을 공개했습니다. 그러나 LLMs의 맥락에서 증류는 딥러닝에서 사용되는 전통적인 지식 증류 접근 방식과 반드시 일치하지 않습니다. 전통적으로 지식 증류(제 Machine Learning Q and AI 책 6장에서 간략히 설명됨)에서는 더 작은 학생 모델이 더 큰 교사 모델의 로짓과 목표 데이터셋 모두에 대해 훈련됩니다.

반면 여기서의 distillation은 Llama 8B와 70B, Qwen 2.5 모델(0.5B에서 32B)과 같은 작은 LLMs를 더 큰 LLMs가 생성한 SFT 데이터셋에서 지시문 미세조정을 의미합니다. 구체적으로, 이 더 큰 LLMs는 DeepSeek-V3와 DeepSeek-R1의 중간 체크포인트입니다. 실제로 이 distillation 과정에 사용된 SFT 데이터는 이전 섹션에서 설명된 대로 DeepSeek-R1을 훈련하는 데 사용된 동일한 데이터셋입니다.

이 과정을 명확히 하기 위해 아래 다이어그램에서 distillation 부분을 강조 표시했습니다.

왜 이러한 정제된 모델을 개발했을까요? 제 생각에는 두 가지 주요 이유가 있습니다:

- 작은 모델은 더 효율적입니다. 이는 실행 비용이 저렴하다는 의미이며, 또한 저사양 하드웨어에서도 실행 가능하기 때문에 저와 같은 많은 연구자와 실험가들에게 특히 매력적입니다.

- 순수 SFT의 사례 연구입니다. 이 정제된 모델들은 순수한 감독형 미세 조정(SFT)이 강화 학습 없이 모델을 얼마나 발전시킬 수 있는지 보여주는 흥미로운 벤치마크 역할을 합니다.

아래 표는 이 정제된 모델들의 성능을 다른 인기 모델들과 비교하며, DeepSeek-R1-Zero 및 DeepSeek-R1과의 비교도 포함합니다.

우리는 볼 수 있듯이, 정제된 모델들은 DeepSeek-R1에 비해 눈에 띄게 약하지만, DeepSeek-R1-Zero에 비해 놀랍도록 강합니다. 이는 규모가 수십 배나 작은 모델임에도 불구하고입니다. 또한 이 모델들이 o1 mini와 비교했을 때 얼마나 잘 수행되는지 주목할 만합니다(o1-mini 자체도 o1의 유사한 정제 버전일 수 있다고 추측됩니다).

이 섹션을 결론으로 마무리하기 전에 한 가지 더 흥미로운 비교를 언급할 가치가 있습니다. DeepSeek 팀은 DeepSeek-R1-Zero에서 관찰된 신흥 추론 행동이 더 작은 모델에서도 나타날 수 있는지 테스트했습니다. 이를 조사하기 위해 그들은 DeepSeek-R1-Zero에서 사용된 동일한 순수 RL 접근법을 Qwen-32B에 직접 적용했습니다.

이 실험의 결과는 아래 표에 요약되어 있으며, QwQ-32B-Preview는 Qwen 팀이 개발한 Qwen 2.5 32B를 기반으로 한 참조 추론 모델로 사용되었습니다(훈련 세부 사항은 공개되지 않은 것으로 알고 있습니다). 이 비교는 순수 RL alone이 DeepSeek-R1-Zero보다 훨씬 작은 모델에서도 추론 능력을 유도할 수 있는지 여부에 대한 추가적인 통찰을 제공합니다.

흥미롭게도, 결과는 작은 모델에 대해 증류가 순수한 RL보다 훨씬 더 효과적임을 보여줍니다. 이는 순수한 RL만으로는 이 규모의 모델에서 강력한 추론 능력을 유도하기에 충분하지 않을 수 있다는 아이디어와 일치합니다. 반면, 고품질 추론 데이터에 대한 SFT는 작은 모델을 다룰 때 더 효과적인 전략이 될 수 있습니다.

완전성을 위해 표에 추가 비교를 포함하는 것이 유용했을 것입니다:

- Qwen-32B를 SFT + RL로 훈련시킨 경우(DeepSeek-R1 개발 방식과 유사). 이는 RL을 SFT와 결합했을 때 순수 RL 및 순수 SFT 대비 얼마나 개선될 수 있는지 판단하는 데 도움이 될 것입니다.

- DeepSeek-V3를 순수 SFT로 훈련시킨 경우(증류 모델 생성 방식과 유사). 이는 RL + SFT가 순수 SFT 대비 얼마나 효과적인지 직접 비교할 수 있도록 합니다.

결론

이 섹션에서는 추론 모델을 구축하고 개선하기 위한 네 가지 다른 전략을 탐구했습니다.

- 추론 시간 확장(Inference-time scaling)은 추가 훈련이 필요 없지만 추론 비용을 증가시켜 사용자 수나 쿼리 양이 증가함에 따라 대규모 배포 비용이 상승합니다. 그럼에도 불구하고 이미 강력한 모델의 성능을 개선하는 데는 여전히 가장 간단한 방법입니다. 저는 o1이 추론 시간 확장 전략을 활용한다고 강력히 의심하며, 이는 DeepSeek-R1에 비해 토큰당 비용이 더 높은 이유를 설명해줍니다.

- 순수한 RL은 추론이emergent behavior로 나타나는 과정을 이해하는 데 연구 목적으로 흥미롭습니다. 그러나 실용적인 모델 개발에서는 RL + SFT가 선호되는 접근 방식입니다. 이는 더 강력한 추론 모델을 생성하기 때문입니다. 저는 o1도 RL + SFT를 사용하여 훈련되었다고 강력히 의심합니다. 더 정확히 말하면, o1은 DeepSeek-R1보다 약하고 작은 기본 모델에서 시작하지만, RL + SFT와 추론 시 스케일링으로 이를 보완합니다.

- 위에서 언급된 대로, RL + SFT는 고성능 추론 모델을 구축하는 핵심 접근 방식입니다. DeepSeek-R1은 이를 어떻게 구현할 수 있는지 보여주는 좋은 모델입니다.

- 디스트일레이션은 특히 더 작고 효율적인 모델을 생성하는 데 매력적인 접근 방식입니다. 그러나 디스트일레이션의 한계는 혁신을 주도하거나 다음 세대의 추론 모델을 생성하지 않는다는 점입니다. 예를 들어, 디스트일레이션은 항상 기존에 존재하는 더 강력한 모델을 기반으로 감독형 미세 조정(SFT) 데이터를 생성해야 합니다.

다음에 기대되는 흥미로운 측면은 RL + SFT(접근 방식 3)와 추론 시 확장성(접근 방식 1)을 결합하는 것입니다. 이는 OpenAI o1이 수행 중인 것과 유사하지만, DeepSeek-R1보다 약한 기본 모델을 기반으로 하기 때문에 DeepSeek-R1이 추론 시 상대적으로 저렴하면서도 우수한 성능을 발휘하는 이유를 설명합니다.

Thoughts about DeepSeek R1

최근 몇 주 동안 많은 분들이 DeepSeek-R1 모델에 대한 제 의견을 물어보셨습니다. 간단히 말해, 이 모델들은 정말 놀라운 성과라고 생각합니다. 연구 엔지니어로서, 그들의 방법론을 이해하는 데 도움이 되는 상세한 기술 보고서를 특히 높이 평가합니다.

가장 흥미로운 점 중 하나는 순수한 강화 학습(RL)에서 추론이 자연스럽게 나타난 방식입니다. 또한 DeepSeek가 모델을 Meta의 Llama 모델보다 더 적은 제한을 가진 허용적인 오픈소스 MIT 라이선스로 공개했다는 점도 인상적입니다.

o1과 비교했을 때 어떻게 되나요?

DeepSeek-R1이 o1보다 나은가요? 대략 같은 수준이라고 생각합니다. 그러나 DeepSeek-R1이 추론 시점에 더 효율적이라는 점이 돋보입니다. 이는 DeepSeek가 훈련 과정에 더 많은 자원을 투자했을 가능성이 있으며, OpenAI는 o1에서 추론 시간 확장성에 더 의존했을 수 있음을 시사합니다.

그럼에도 불구하고, OpenAI가 o1에 대해 많은 정보를 공개하지 않았기 때문에 o1과 DeepSeek-R1을 직접 비교하기는 어렵습니다. 예를 들어, 우리는 다음과 같은 점을 모릅니다.

- o1도 Mixture of Experts (MoE)인가요?

- o1의 규모는 얼마나 될까요?

- o1이 GPT-4o에 최소한의 RL + SFT를 추가하고 추론 시 확장만 대폭 강화한 약간 개선된 버전일 수 있을까요?

이러한 세부 사항을 모르면 직접적인 비교는 여전히 사과와 오렌지를 비교하는 것과 같은 비교가 됩니다.

DeepSeek-R1의 훈련 비용

또 다른 논의 포인트는 DeepSeek-R1의 개발 비용입니다. 일부에서는 약 $6백만 달러의 훈련 비용을 언급했지만, 이는 아마도 지난해 12월에 공개된 기본 모델인 DeepSeek-V3와 DeepSeek-R1을 혼동한 것일 가능성이 높습니다.

$6백만 달러 추산치는 GPU 시간당 $2를 가정하고 DeepSeek-V3의 최종 훈련 실행에 필요한 GPU 시간 수를 기반으로 합니다. 이 수치는 2024년 12월에 처음 논의되었습니다.

그러나 DeepSeek 팀은 R1의 정확한 GPU 시간이나 개발 비용을 공개한 적이 없기 때문에, 모든 비용 추정은 순수한 추측에 불과합니다.

어쨌든, DeepSeek-R1은 오픈웨이트 추론 모델 분야에서 중요한 이정표이며, 추론 시 효율성으로 인해 OpenAI의 o1과 경쟁할 수 있는 흥미로운 대안으로 주목받고 있습니다.

Developing reasoning models on a limited budget

DeepSeek-R1 수준의 추론 모델을 개발하려면 DeepSeek-V3와 같은 오픈 소스 기반 모델을 출발점으로 삼더라도 수십만 달러에서 수백만 달러의 비용이 소요될 수 있습니다. 이는 제한된 예산으로 연구나 개발을 진행하는 연구자나 엔지니어들에게는 부담스러울 수 있습니다.

좋은 소식: 증류가 큰 도움이 될 수 있습니다

다행히 모델 디스트릴레이션은 더 비용 효율적인 대안을 제공합니다. DeepSeek 팀은 R1-디스트릴레이션 모델을 통해 이를 입증했습니다. 이 모델은 DeepSeek-R1보다 훨씬 작은 규모임에도 불구하고 놀랍도록 강력한 추론 성능을 보여줍니다. 그러나 이 접근 방식도 완전히 저렴하지는 않습니다. 그들의 디스트릴레이션 과정에는 800K SFT 샘플이 사용되었으며, 이는 상당한 컴퓨팅 자원을 요구합니다.

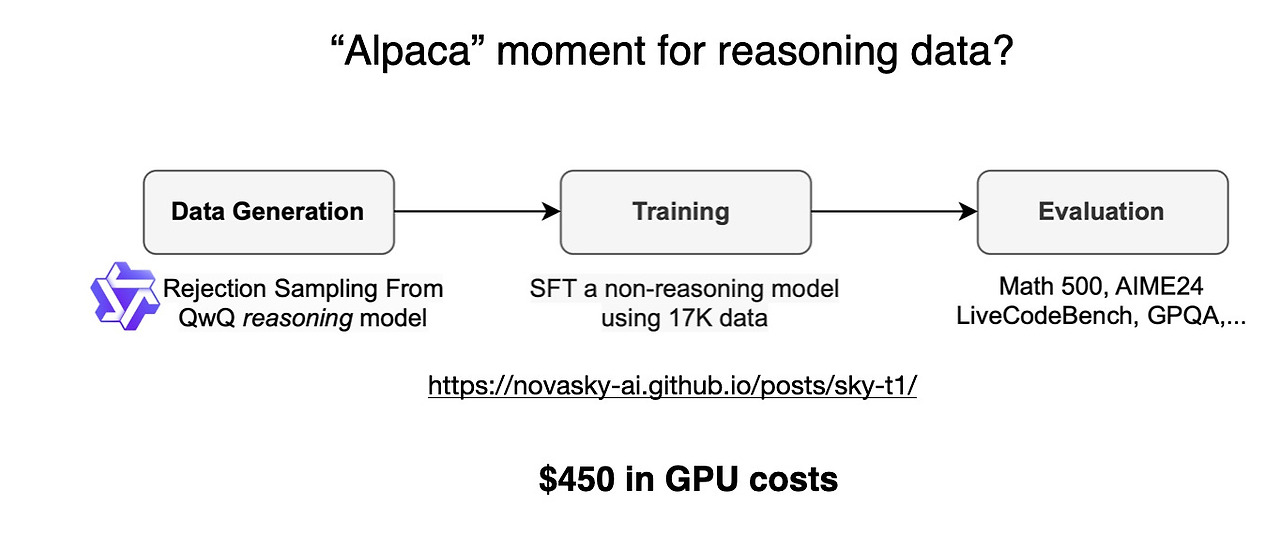

흥미롭게도 DeepSeek-R1이 공개되기 불과 며칠 전, Sky-T1이라는 흥미로운 프로젝트에 대한 기사를 접했습니다. 이 프로젝트에서는 소규모 팀이 17K SFT 샘플만을 사용해 오픈 웨이트 32B 모델을 훈련했습니다. 총 비용은 단 $450로, 대부분의 AI 컨퍼런스 등록비보다 저렴합니다.

이 사례는 대규모 훈련이 여전히 비용이 많이 드는 반면, 작은 규모로 타겟팅된 미세 조정 노력은 비용의 일부만으로 인상적인 결과를 얻을 수 있음을 보여줍니다.

그들의 벤치마크에 따르면, Sky-T1은 o1과 비슷한 성능을 보여줍니다. 이는 낮은 훈련 비용을 고려할 때 인상적인 결과입니다.

예산 내 Pure RL: TinyZero

Sky-T1이 모델 정제화에 초점을 맞췄다면, 저는 "순수 RL" 분야에서 흥미로운 연구를 몇 가지 발견했습니다. 그 중 하나가 TinyZero로, 3B 파라미터 모델로 DeepSeek-R1-Zero 접근법을 재현합니다(참고: 훈련 비용이 $30 미만입니다).

놀랍게도 3B 파라미터만으로도 TinyZero는 일부 자체 검증 능력을 보여주며, 이는 작은 모델에서도 순수 RL을 통해 추론이 자연스럽게 발생할 수 있음을 시사합니다.

TinyZero 저장소에는 연구 보고서가 아직 진행 중이라고 언급되어 있으며, 추가 세부 사항을 주시할 예정입니다.

위에서 언급된 두 프로젝트는 제한된 예산으로도 추론 모델에 대한 흥미로운 연구가 가능함을 보여줍니다. 두 접근 방식 모두 DeepSeek-R1의 방법을 재현하지만, 하나는 순수한 강화 학습(RL)에 초점을 맞춘 TinyZero이고 다른 하나는 순수한 시퀀스 포밍 트레이닝(SFT)에 초점을 맞춘 Sky-T1입니다. 이러한 아이디어를 어떻게 더 확장할 수 있을지 탐구하는 것은 매우 흥미로운 과제입니다.

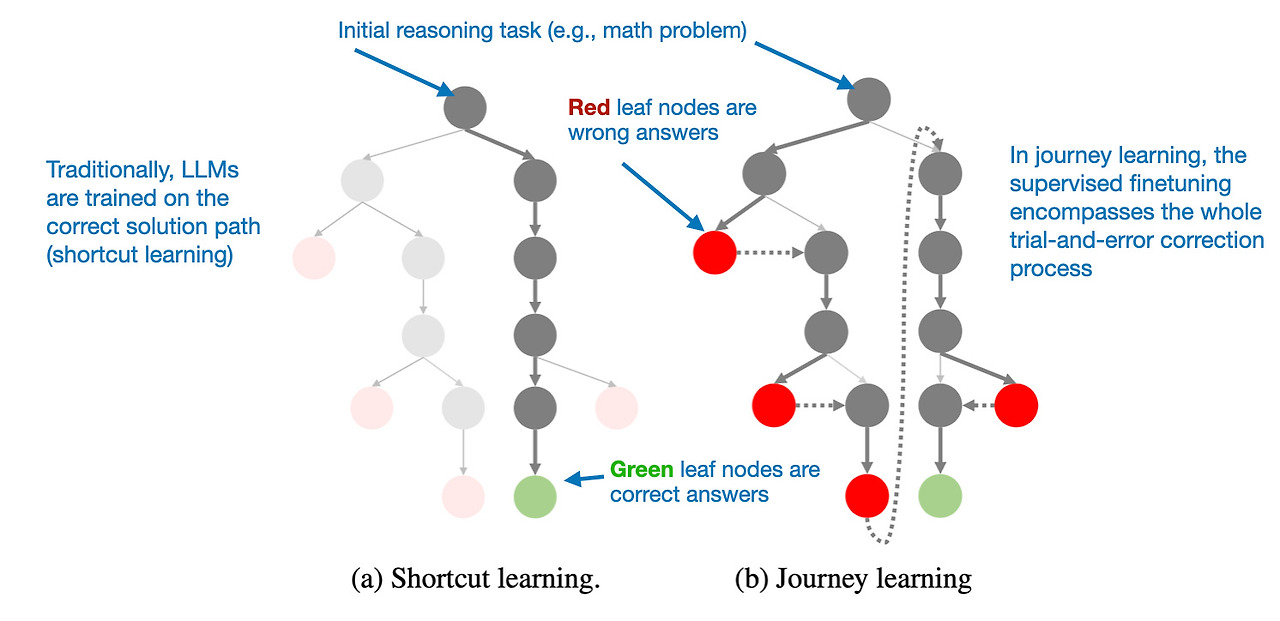

전통적인 SFT를 넘어: 여정 학습

지난해 접한 특히 흥미로운 접근 방식은 논문 O1 Replication Journey: A Strategic Progress Report – Part 1에 설명되어 있습니다. 제목과 달리 이 논문은 실제로 O1을 재현하지 않습니다. 대신, 순수 SFT(Distillation) 과정을 개선하기 위한 다른 방법을 소개합니다.

이 논문의 핵심 아이디어는 "shortcut learning"의 대안으로 제시된 "journey learning"입니다.

- Shortcut learning은 지시문 미세조정의 전통적인 접근 방식으로, 모델을 올바른 해결 경로만을 사용하여 훈련하는 것을 의미합니다.

- 반면 journey learning은 잘못된 해결 경로도 포함하여 모델이 오류로부터 학습할 수 있도록 합니다.

이 접근 방식은 TinyZero의 순수 RL 훈련에서 관찰된 자기 검증 능력과 유사하지만, SFT를 통해 모델을 완전히 개선하는 데 초점을 맞춥니다. 잘못된 추론 경로와 그 교정을 모델에 노출시킴으로써, 여정 학습은 자기 교정 능력을 강화할 수 있으며, 이로써 추론 모델의 신뢰성을 높일 수 있습니다.

이 방향은 미래 연구에 흥미로운 방향이 될 수 있으며, 특히 계산적으로 실용적이지 않을 수 있는 RL 기반 접근 방식이 적용되는 저예산 추론 모델 개발 분야에서 특히 그렇습니다.

어쨌든, 추론 모델 분야에서는 현재 많은 흥미로운 연구가 진행 중이며, 앞으로 몇 달 안에 더 많은 흥미로운 연구 결과가 나올 것이라 확신합니다!

'AI-ML > LLM' 카테고리의 다른 글

| LLM에서 Self-Attention, Multi-Head Attention, Causal-Attention, 및 Cross-Attention의 이해와 Code 해석 (6) | 2025.08.11 |

|---|---|

| GPT-2에서 gpt-oss로: 아키텍처적 개선점 분석 (4) | 2025.08.10 |

| 대규모 언어 모델(LLM) 아키텍처 비교 (2) | 2025.07.22 |

| Amazon Sagemaker JupyterLab Kernel 설정하기 (0) | 2025.02.21 |

| AWS Certified AI Practitioner 합격기(AIF-C01) (0) | 2024.08.29 |