인기 있는 소셜 미디어 웹 사이트는 전 세계 수백만명의 사용자들에게 정적 컨텐츠를 제공하기 위해 CloudFront웹 배포를 사용합니다. 그들은 최근 그들의 사용자들이 그들의 웹 사이트에 로그인하는데 많은 시간이 걸린다는 많은 불평을 받고 있다. 사용자가 HTTP504오류를 받는 경우도 있습니다. 시스템을 더욱 최적화하기 위해 사용자의 로그인 시간을 크게 줄이라는 관리자의 지시를 받았습니다.

다음 중 애플리케이션 성능을 개선할 수 있는 비용 효율적인 솔루션을 설정하기 위해 함께 사용해야 하는 옵션은 무엇입니까? (2개 선택)

-

전 세계 사용자를 수용할 수 있도록 여러 AWS영역에 애플리케이션을 배포합니다. 대기 시간 라우팅 정책을 사용하여 Rotue53 경로 레코드를 설정하면 사용자에게 가장 적합한 대기 시간을 제공하는 영역으로 들어오는 트래픽을 라우팅

-

CloudFront웹 배포가 사용자에게 제공하는 컨텐츠를 Lambdam@Edge를 사용하여 사용자 정의하면 람다 기능이 사용자와 가까운 AWS위치에서 인증 프로세스를 실행할 수 있습니다.

-

지역에 분산되어 있는 VPC를 다양한 AWS영역에 사용한 다음 모든 리소스를 연결하는 통과 VPC를 생성합니다. 요청을 더 빨리 처리하기 위해 위에서 설명한 것과 동일한 이유로 인해 AWS SAM(ServerlessApplicationModel)서비스를 사용하여 각 지역에서 람다 기능을 설정

-

원본을 구성하여 추가하기Cache-Control max-age개체에 대한 지침을 제공하고 가장 긴 실제 값을 지정합니다.max-ageCloudFront배포의 캐시 적중률을 높이는 것

-

두개의 원점으로 된 오리진 그룹을 생성하여 오리진 페일 오버를 설정합니다. 하나는 기본 오리진으로, 다른 하나는 기본 오리진이 특정 HTTP상태 코드 오류 응답을 반환할 때 CloudFront가 자동으로 전환하는 두번째 오리진으로 지정하십시오.

Lambdam@Edge를 사용하면 CloudFront가 제공하는 콘텐츠를 사용자 정의하여 뷰어에 가까운 AWS위치에서 기능을 실행할 수 있습니다. 이 기능은 서버를 프로비저닝 하거나 관리하지 않고 CloudFront이벤트에 대한 응답으로 실행됩니다. 람다 기능을 사용하여 다음 지점에서 CloudFront요청 및 응답을 변경할 수 있습니다.

-

CloudFront가 뷰어로부터 요청을 수신한 후(뷰어 요청)

-

CloudFront가 요청을 원래 요청(원본 요청)으로 전달하기 전에

-

CloudFront가 원본으로부터 응답을 수신한 후(원본 응답)

-

CloudFront가 응답을 뷰어에 전달하기 전에(뷰어 응답)

지정된 시나리오에서 Lambda@Edge를 사용하여 CloudFront가 제공하는 컨텐츠를 람다 기능에서 사용자 정의하고 사용자와 가까운 AWS위치에서 인증 프로세스를 실행할 수 있습니다. 또한 하나는 기본 원본으로, 다른 하나는 기본 원본으로, 다른 하나는 기본 원본이 실패할 때 자동으로 전환되는 원본 그룹을 생성하여 오리진 페일 오버를 설정할 수 있습니다. 이를 통해 사용자가 겪는 간헐적인 HTTP504오류를 줄일 수 있습니다.

여러 지역에 분산되어 있는 VPC를 다양한 AWS영역에 사용한 다음 모든 리소스를 연결하는 통과 VPC를 생성합니다. 요청을 더 빨리 처리하기 위해 위에서 설명한 것과 동일한 이유로 인해 AWS SAM(ServerlessApplicationModel)서비스를 사용하여 각 지역에서 람다 기능을 설정하는 것은 잘못된 것입니다. 전송 VPC와 연결되는 다양한 영역에 걸쳐 여러 VPC를 설정하는 것은 유효하지만 이 솔루션은 설정 및 유지 관리 비용이 더 높습니다. 보다 비용 효율적인 옵션은 Lambda@Edge를 대신 사용하는 것입니다.

원본을 구성하여 추가하기Cache-Control max-age개체에 대한 지침을 제공하고 가장 긴 실제 값을 지정합니다. max-age값으로 CloudFront배포의 캐시 적중률을 높이는 것은 이 시나리오에서는 CloudFront배포의 캐시 적중률을 개선하는 것이 무관하기 때문에 잘못된 것입니다. 원본 서버로 컨텐츠를 이동하는 대신 CloudFront에지 캐시에서 제공되는 뷰어 요청 비율을 늘려 캐시 성능을 향상시킬 수 있습니다. 하지만 이 시나리오의 문제는 정적 개체의 캐슁뿐만 아니라 글로벌 사용자의 느린 인증 프로세스입니다.

전 세계 사용자를 수용할 수 있도록 여러 AWS영역에 애플리케이션을 배포합니다. 대기 시간 라우팅 정책을 사용하여 53번 경로 레코드를 설정하면 사용자에게 가장 적합한 대기 시간을 제공하는 영역으로 들어오는 트래픽을 라우팅 하는 것이 올바르지 않습니다. 이렇게 하면 성능 문제가 해결될 수 있지만 이 솔루션을 여러 AWS영역에 배포해야 하기 때문에 상당한 구축 비용이 소요됩니다. 이 시나리오에서는 최소한의 비용으로 애플리케이션 성능을 개선할 솔루션을 요구합니다.

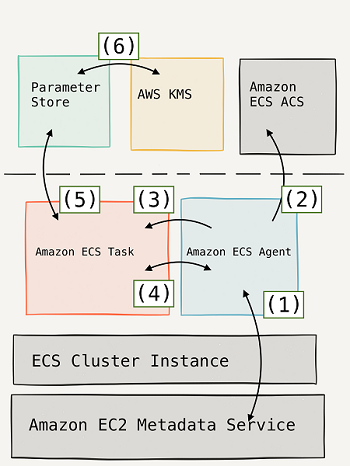

Amazon ECS를 사용하면 민감한 데이터를 AWS Secrets Manager 암호 또는 AWS Systems Manager Parameter Store 파라미터에 저장 한 다음 컨테이너 정의에서 참조하여 민감한 데이터를 컨테이너에 주입 할 수 있습니다. 이 기능은 EC2 및 Fargate 시작 유형을 모두 사용하는 작업에서 지원됩니다.

비밀은 다음과 같은 방법으로 컨테이너에 노출 될 수 있습니다.

-

민감한 데이터를 환경 변수로 컨테이너에 주입하려면 secrets컨테이너 정의 매개 변수를 사용하세요.

-

컨테이너의 로그 구성에서 민감한 정보를 참조하려면 secretOptions컨테이너 정의 매개 변수를 사용하십시오.

컨테이너 정의 내에서 컨테이너 secrets에 설정할 환경 변수의 이름과 컨테이너에 제공 할 민감한 데이터가 포함 된 Secrets Manager 암호 또는 Systems Manager Parameter Store 파라미터의 전체 ARN을 지정합니다. 참조하는 매개 변수는 해당 매개 변수를 사용하는 컨테이너와 다른 리전에있을 수 있지만 동일한 계정 내에 있어야합니다.

클라이언트 측 암호화 는 데이터를 Amazon S3로 보내기 전에 암호화하는 작업입니다. 클라이언트 측 암호화를 사용하려면 다음 옵션이 있습니다.

-

AWS KMS 관리 형 고객 마스터 키를 사용합니다.

-

클라이언트 측 마스터 키를 사용합니다.

AWS KMS 관리 형 고객 마스터 키를 사용하여 클라이언트 측 데이터 암호화를 활성화하는 경우 AWS KMS 고객 마스터 키 ID (CMK ID)를 AWS에 제공합니다. 반면에 클라이언트 측 데이터 암호화에 클라이언트 측 마스터 키를 사용하면 클라이언트 측 마스터 키와 암호화되지 않은 데이터가 AWS로 전송되지 않습니다. 암호화 키를 잃어 버리면 데이터를 해독 할 수 없기 때문에 안전하게 관리하는 것이 중요합니다.

다음은 클라이언트 측 마스터 키를 사용한 클라이언트 측 암호화가 작동하는 방식입니다.

객체를 업로드 할 때 - Amazon S3 암호화 클라이언트에 클라이언트 측 마스터 키를 제공합니다. 클라이언트는 무작위로 생성하는 데이터 암호화 키를 암호화하는 데만 마스터 키를 사용합니다. 프로세스는 다음과 같이 작동합니다.

-

Amazon S3 암호화 클라이언트는 일회용 대칭 키 (데이터 암호화 키 또는 데이터 키라고도 함)를 로컬로 생성합니다. 데이터 키를 사용하여 단일 Amazon S3 객체의 데이터를 암호화합니다. 클라이언트는 각 개체에 대해 별도의 데이터 키를 생성합니다.

-

클라이언트는 사용자가 제공 한 마스터 키를 사용하여 데이터 암호화 키를 암호화합니다. 클라이언트는 암호화 된 데이터 키와 해당 재료 설명을 객체 메타 데이터의 일부로 업로드합니다. 클라이언트는 자료 설명을 사용하여 암호 해독에 사용할 클라이언트 측 마스터 키를 결정합니다.

-

클라이언트는 암호화 된 데이터를 Amazon S3에 업로드하고 암호화 된 데이터 키를 Amazon S3에 객체 메타 데이터 x-amz-meta-x-zmx-key 로 저장합니다.

객체를 다운로드 할 때 - 클라이언트는 Amazon S3에서 암호화 된 객체를 다운로드합니다. 클라이언트는 객체 메타 데이터의 재료 설명을 사용하여 데이터 키를 해독하는 데 사용할 마스터 키를 결정합니다. 클라이언트는 해당 마스터 키를 사용하여 데이터 키를 해독 한 다음 데이터 키를 사용하여 개체를 해독합니다.

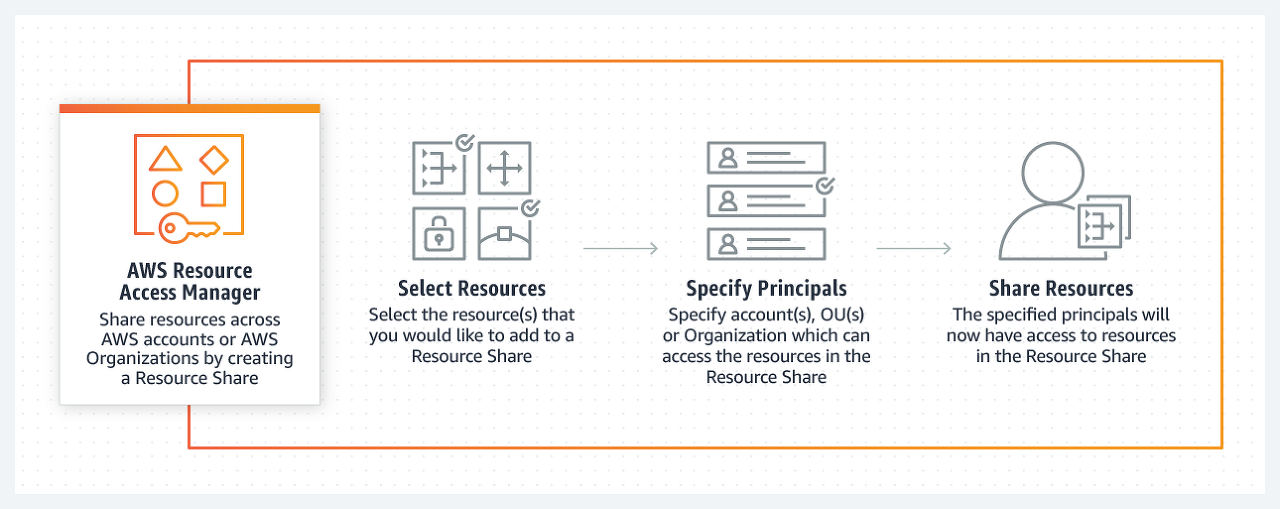

AWS Resource Access Manager (RAM)는 AWS 계정 또는 AWS 조직 내에서 AWS 리소스를 쉽고 안전하게 공유 할 수있는 서비스입니다. AWS Transit Gateway, 서브넷, AWS License Manager 구성 및 Amazon Route 53 Resolver 규칙 리소스를 RAM과 공유 할 수 있습니다.

많은 조직에서 여러 계정을 사용하여 관리 또는 청구 격리를 만들고 오류의 영향을 제한합니다. RAM을 사용하면 여러 계정에서 중복 리소스를 만들 필요가 없으므로 소유 한 모든 단일 계정에서 해당 리소스를 관리하는 작업 오버 헤드가 줄어 듭니다. 다중 계정 환경에서 중앙 집중식으로 리소스를 생성하고 RAM을 사용하여 리소스 공유 생성, 리소스 지정 및 계정 지정이라는 세 가지 간단한 단계로 계정간에 해당 리소스를 공유 할 수 있습니다. RAM은 추가 비용없이 사용할 수 있습니다.

AWS 리소스를 중앙에서 조달하고 RAM을 사용하여 서브넷 또는 라이선스 관리자 구성과 같은 리소스를 다른 계정과 공유 할 수 있습니다. 이렇게하면 다중 계정 환경의 모든 계정에 중복 리소스를 프로비저닝 할 필요가 없으므로 모든 계정에서 해당 리소스를 관리하는 운영 오버 헤드가 줄어 듭니다.

AWS Organizations는 여러 AWS 계정을 생성하고 중앙에서 관리하는 조직으로 통합 할 수있는 계정 관리 서비스입니다. 조직을 사용하면 구성원 계정을 만들고 기존 계정을 조직에 초대 할 수 있습니다. 이러한 계정을 그룹으로 구성하고 정책 기반 제어를 연결할 수 있습니다.

예약 인스턴스 (RI)는 온 디맨드 인스턴스 요금에 비해 상당한 할인 (최대 75 %)을 제공합니다. 컨버터블 RI를 사용할 때 RI 가격의 혜택을 누리면서 제품군, OS 유형 및 테넌시를 유연하게 변경할 수 있습니다. 여기서 기억해야 할 한 가지 중요한 점은 예약 인스턴스가 물리적 인스턴스가 아니라 계정의 온 디맨드 인스턴스 사용에 적용되는 결제 할인이라는 것입니다.

컴퓨팅 요구 사항이 변경되면 표준 또는 전환 형 예약 인스턴스를 수정하고 계속해서 결제 혜택을 활용할 수 있습니다. 예약 인스턴스의 가용 영역, 범위, 네트워크 플랫폼 또는 인스턴스 크기 (동일한 인스턴스 유형 내)를 수정할 수 있습니다. 예약 인스턴스 마켓 플레이스에서 사용하지 않은 인스턴스를 판매 할 수도 있습니다.

암호화를 통해 저장 및 전송 중 AWS 데이터의 개인 정보를 보호 할 수 있습니다. 데이터가 EBS 볼륨에 저장되어있는 경우 EBS 암호화를 활성화하고 Amazon S3에 저장된 경우 클라이언트 측 및 서버 측 암호화를 활성화 할 수 있습니다 .

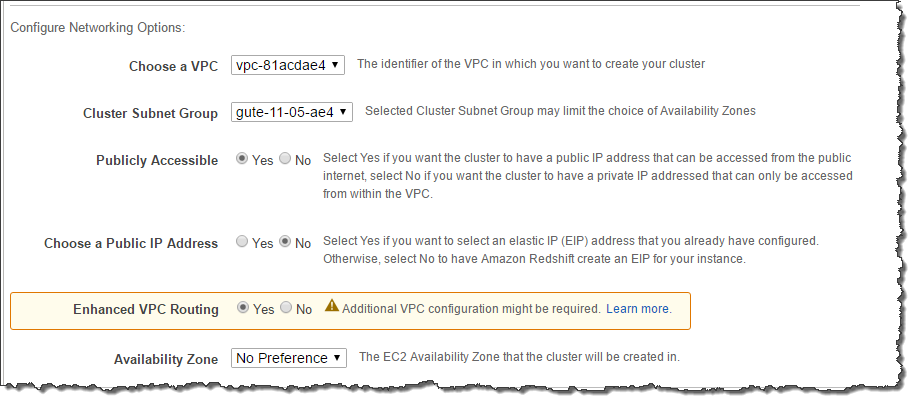

Amazon Redshift Enhanced VPC Routing을 사용할 때 Amazon Redshift는 Amazon VPC를 통해 클러스터와 데이터 리포지토리 간의 모든 COPY 및 UNLOAD 트래픽을 강제로 수행합니다. Enhanced VPC Routing을 사용하면 VPC 보안 그룹, 네트워크 액세스 제어 목록 (ACL), VPC 엔드 포인트, VPC 엔드 포인트 정책, 인터넷 게이트웨이 및 DNS (Domain Name System) 서버와 같은 표준 VPC 기능을 사용할 수 있습니다. 따라서 Amazon Redshift 클러스터에서 향상된 VPC 라우팅을 활성화하는 것이 정답입니다.

이러한 기능을 사용하여 Amazon Redshift 클러스터와 다른 리소스 간의 데이터 흐름을 엄격하게 관리합니다. Enhanced VPC Routing을 사용하여 VPC를 통해 트래픽을 라우팅 할 때 VPC 흐름 로그를 사용하여 COPY 및 UNLOAD 트래픽을 모니터링 할 수도 있습니다. Enhanced VPC Routing이 활성화되지 않은 경우 Amazon Redshift는 AWS 네트워크 내의 다른 서비스에 대한 트래픽을 포함하여 인터넷을 통해 트래픽을 라우팅합니다.

감사 로깅 기능은 주로 Redshift 클러스터 의 연결, 쿼리 및 사용자 활동에 대한 정보를 가져 오는 데 사용되기 때문에 Amazon Redshift 클러스터에서 감사 로깅을 활성화하는 것은 올바르지 않습니다.

Amazon Redshift Spectrum 기능 은 주로로드 또는 ETL없이 Amazon S3에서 엑사 바이트 규모의 비정형 데이터에 대해 쿼리를 실행하는 데 사용되기 때문에 잘못된 것입니다.

Amazon Redshift 클러스터의 트래픽을 추적하는 새 흐름 로그를 생성하는 것은 기본적으로 Amazon Redshift 클러스터에 대한 흐름 로그를 생성 할 수 없기 때문에 올바르지 않습니다. Enhanced VPC Routing을 활성화하고 필요한 VPC 구성을 설정해야합니다.

DynamoDB 와 ElastiCache 가 정답입니다. 세션 상태 데이터를 DynamoDB와 ElastiCache 모두에 저장할 수 있습니다. 이러한 AWS 서비스는 고 가용성 웹 애플리케이션을 구축하는 데 사용할 수있는 키-값 쌍의 고성능 스토리지를 제공합니다.

Redshift Spectrum 은 데이터웨어 하우스에서 데이터를 직접 쿼리 할 수있는 데이터웨어 하우징 솔루션이므로 올바르지 않습니다. Redshift는 세션 상태를 저장하는 데 적합하지 않지만 분석 및 OLAP 프로세스에 더 적합합니다.

RDS 는 AWS의 관계형 데이터베이스 솔루션이므로 부정확합니다. 이 관계형 스토리지 유형은 세션 상태에 가장 적합하지 않을 수 있으며 동일한 비용으로 DynamoDB에 비해 필요한 성능을 제공하지 못할 수 있습니다.

S3 Glacier 는 데이터 보관 및 장기 백업을위한 저렴한 클라우드 스토리지 서비스이기 때문에 부정확합니다. Glacier의 보관 및 검색 속도가 세션 상태를 처리하기에 너무 느립니다.

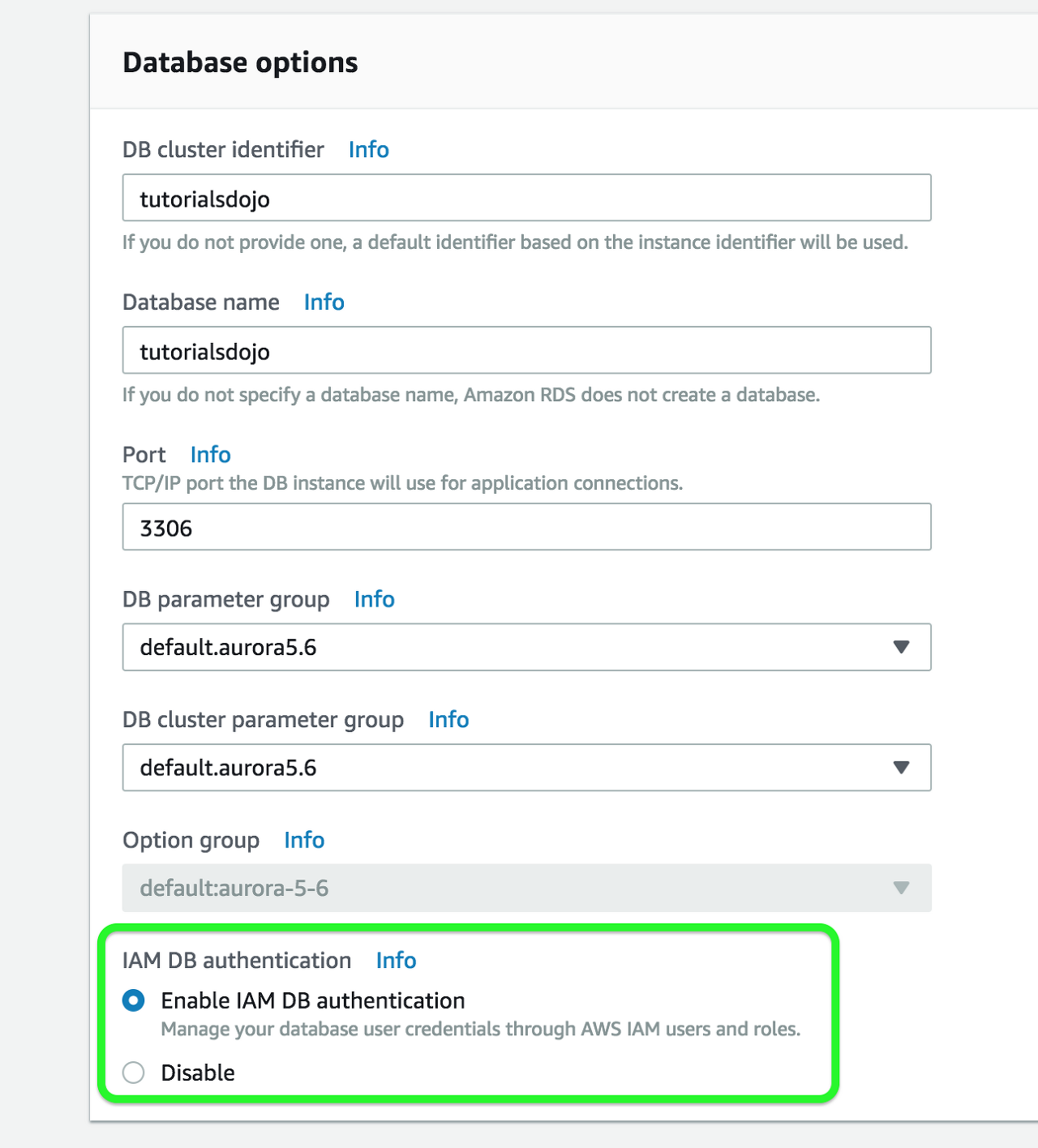

AWS Identity and Access Management (IAM) 데이터베이스 인증을 사용하여 DB 인스턴스에 인증 할 수 있습니다. IAM 데이터베이스 인증은 MySQL 및 PostgreSQL에서 작동합니다. 이 인증 방법을 사용하면 DB 인스턴스에 연결할 때 암호를 사용할 필요가 없습니다. 대신 인증 토큰을 사용합니다.

인증 토큰은 아마존 RDS는 요청을 생성하는 문자의 고유 한 문자열입니다. 인증 토큰은 AWS 서명 버전 4를 사용하여 생성됩니다. 각 토큰의 수명은 15 분입니다. 인증은 IAM을 사용하여 외부에서 관리되므로 데이터베이스에 사용자 자격 증명을 저장할 필요가 없습니다. 표준 데이터베이스 인증을 계속 사용할 수도 있습니다.

IAM 데이터베이스 인증은 다음과 같은 이점을 제공합니다.

-

데이터베이스를 오가는 네트워크 트래픽은 SSL (Secure Sockets Layer)을 사용하여 암호화됩니다.

-

각 DB 인스턴스에서 개별적으로 액세스를 관리하는 대신 IAM을 사용하여 데이터베이스 리소스에 대한 액세스를 중앙에서 관리 할 수 있습니다.

-

Amazon EC2에서 실행되는 애플리케이션의 경우 보안 강화를 위해 암호 대신 EC2 인스턴스에 고유 한 프로필 자격 증명을 사용하여 데이터베이스에 액세스 할 수 있습니다.

DynamoDB의 스트림은 아마존 DynamoDB의 테이블에있는 항목의 변경 사항에 대한 정보의 순서 흐름입니다. 테이블에서 스트림을 활성화하면 DynamoDB는 테이블의 데이터 항목에 대한 모든 수정 사항에 대한 정보를 캡처합니다.

애플리케이션이 테이블의 항목을 생성, 업데이트 또는 삭제할 때마다 DynamoDB Streams는 수정 된 항목의 기본 키 속성을 사용하여 스트림 레코드를 작성합니다. 스트림 기록은 DynamoDB의 테이블에서 하나의 항목에 대한 데이터 수정에 대한 정보가 포함되어 있습니다. 스트림 레코드가 수정 된 항목의 "이전"및 "이후"이미지와 같은 추가 정보를 캡처하도록 스트림을 구성 할 수 있습니다.

Amazon DynamoDB는 AWS Lambda와 통합되어 있으므로 DynamoDB 스트림의 이벤트에 자동으로 응답하는 코드 조각 인 트리거 를 생성 할 수 있습니다 . 트리거를 사용하면 DynamoDB 테이블의 데이터 수정에 반응하는 애플리케이션을 구축 할 수 있습니다.

테이블에서 DynamoDB 스트림을 활성화하면 스트림 ARN을 작성한 Lambda 함수와 연결할 수 있습니다. 테이블의 항목이 수정 된 직후 테이블의 스트림에 새 레코드가 나타납니다. AWS Lambda는 스트림을 폴링하고 새 스트림 레코드를 감지하면 Lambda 함수를 동기식으로 호출합니다. Lambda 함수는 알림 보내기 또는 워크 플로 시작과 같이 지정한 모든 작업을 수행 할 수 있습니다.

따라서이 시나리오의 정답은 DynamoDB 스트림 활성화 및 AWS Lambda 트리거 생성과 Lambda 함수가 런타임에 필요한 모든 권한을 포함하는 IAM 역할을 생성하는 옵션입니다 . 스트림 레코드의 데이터는 Lambda 함수에 의해 처리되고 SNS 주제에 메시지를 게시하여 이메일을 통해 구독자에게 알립니다.

옵션 : Kinesis Client Library (KCL)를 사용하여 DynamoDB Streams 엔드 포인트에서 데이터를 가져올 DynamoDB Streams Kinesis 어댑터를 활용하는 애플리케이션을 작성합니다. 특정 사용자가 업데이트 한 경우 SNS를 사용하여 이메일을 통해 구독자에게 알립니다. 이는 유효한 솔루션이지만 DynamoDB 스트림을 활성화하는 중요한 단계가 없기 때문입니다. DynamoDB Streams Kinesis Adapter를 설치하면 DynamoDB Streams 엔드 포인트에서 원활하게 전달되는 API 호출로 KCL 인터페이스를 통해 애플리케이션 개발을 시작할 수 있습니다. DynamoDB 스트림 기능은 기본적으로 활성화되어 있지 않습니다.

옵션 : DynamoDB Streams 엔드 포인트에서 데이터를 가져 오는 DynamoDB Streams Kinesis 어댑터를 사용하는 Lambda 함수를 생성합니다. 위와 같이 엔드 포인트를 사용하려면 먼저 DynamoDB 스트림을 수동으로 활성화해야하므로 특정 사용자 가 업데이트 한 내용 이 잘못된 경우 이메일을 통해 구독자에게 알리는 SNS 주제를 설정합니다.

옵션 : 소스 DynamoDB 테이블에 액세스하도록 DAX 클러스터를 설정합니다. 새 DynamoDB 트리거와 Lambda 함수를 생성합니다. 사용자 데이터의 모든 업데이트에 대해 트리거는 데이터를 Lambda 함수로 전송 한 다음 DynamoDB Accelerator (DAX) 기능이 주로 인 메모리 읽기 성능을 크게 향상시키는 데 사용되기 때문에 SNS를 사용하여 이메일을 통해 구독자에게 알립니다. 항목 수준 수정의 시간 순서 시퀀스를 캡처하지 않습니다. 이 시나리오에서는 대신 DynamoDB 스트림을 사용해야합니다.

AI 기반 Forex 거래 애플리케이션은 수천 개의 데이터 세트를 사용하여 머신 러닝 모델을 학습시킵니다. 애플리케이션의 워크로드에는 훈련 데이터 세트를 동시에 처리하기위한 고성능 병렬 핫 스토리지가 필요합니다. 또한 수익이 낮은 데이터 세트를 보관하려면 비용 효율적인 콜드 스토리지가 필요합니다.

다음 중 개발자가 사용해야하는 Amazon 스토리지 서비스는 무엇입니까?

-

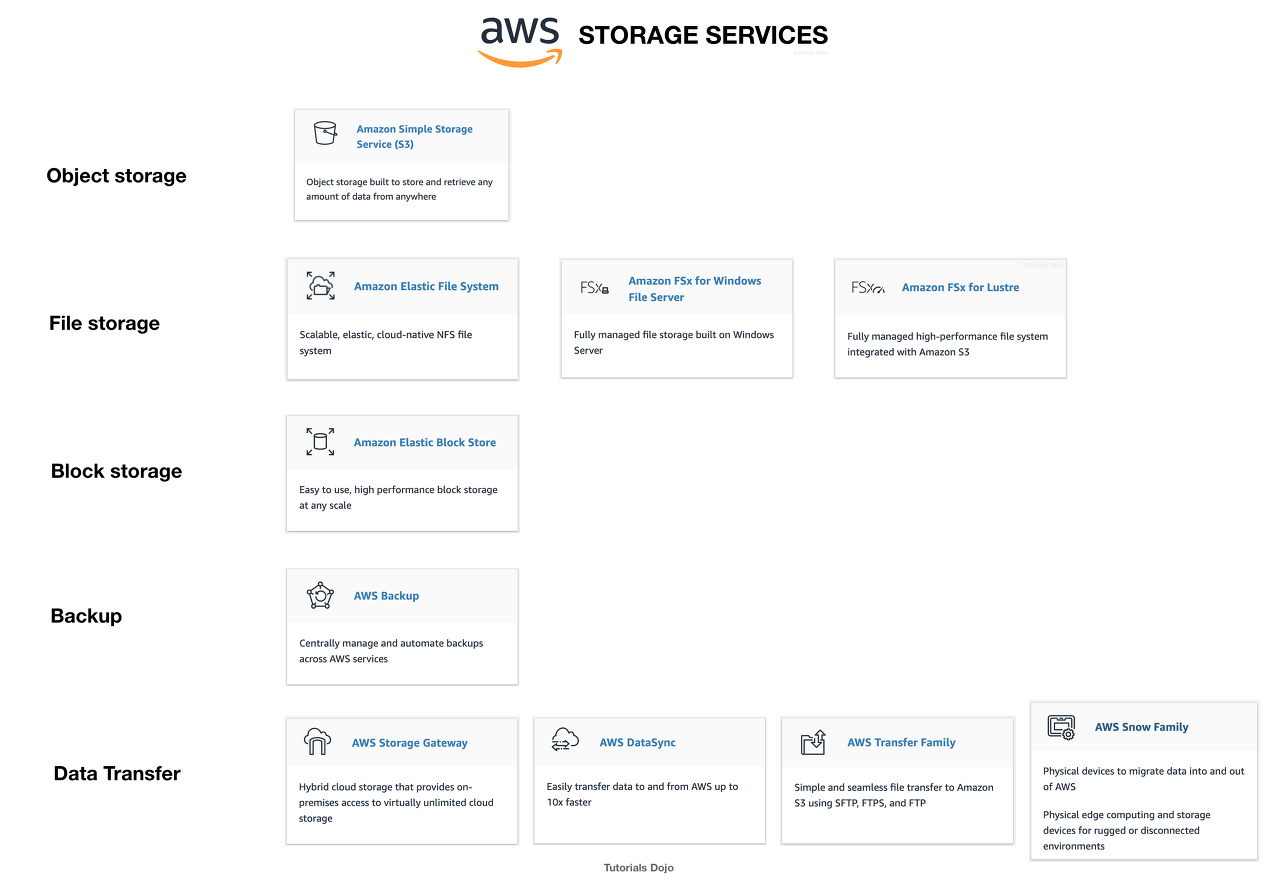

Amazon FSx Fro Luster 및 Amazon S3를 각각 핫 스토리지 및 콜드 스토리지에 사용합니다.

-

핫 스토리지와 콜드 스토리지에 각각 Amazon Elastic File System과 Amazon S3를 사용합니다.

-

Amazon FSx For Luster 및 Amazon EBS 프로비저닝 된 IOPS SSD(io1) 볼륨을 각각 핫 스토리지 및 콜드 스토리지에 사용합니다.

-

Amazon FSx For Windows File Server 및 Amazon S3 를 각각 핫 스토리지 및 콜드 스토리지에 사용합니다.

핫 스토리지 는 자주 액세스하는 데이터 (핫 데이터)를 보관하는 스토리지를 의미합니다. 웜 스토리지 는 액세스 빈도가 낮은 데이터 (웜 데이터)를 보관하는 스토리지를 의미합니다. 콜드 스토리지 는 거의 액세스하지 않는 데이터 (콜드 데이터)를 보관하는 스토리지를 의미합니다. 가격 측면에서 데이터의 온도가 낮을수록 저장 비용이 저렴하며 필요할 때 액세스하는 데 비용이 많이 듭니다.

Amazon FSx For Luster 는 빠른 워크로드 처리를위한 고성능 파일 시스템입니다. Lustre는 성능을 극대화하고 병목 현상을 줄이기 위해 여러 네트워크 파일 서버에 데이터를 저장 하는 인기있는 오픈 소스 병렬 파일 시스템 입니다.

Windows 파일 서버용 Amazon FSx 는 SMB 프로토콜, Windows NTFS, Microsoft Active Directory (AD) 통합을 완벽하게 지원하는 완전 관리 형 Microsoft Windows 파일 시스템입니다.

Amazon Elastic File System 은 Amazon Cloud에서 파일 스토리지를 쉽게 설정하고 확장 할 수있는 완전 관리 형 파일 스토리지 서비스입니다.

Amazon S3는 업계 최고의 확장 성, 데이터 가용성, 보안 및 성능을 제공하는 객체 스토리지 서비스입니다. S3는 다양한 사용 사례 (자주 액세스하는 데이터, 자주 액세스하지 않는 데이터, 거의 액세스하지 않는 데이터)에 대해 서로 다른 스토리지 계층을 제공합니다.

질문에는 두 가지 요구 사항이 있습니다.

-

훈련 데이터 세트를 동시에 처리하기위한 고성능 병렬 핫 스토리지.

-

자주 액세스하지 않는 아카이브 된 데이터 세트를 보관하는 비용 효율적인 콜드 스토리지

이 경우 핫 데이터를위한 고성능 병렬 파일 시스템을 제공하므로 첫 번째 요구 사항에 Amazon FSx For Luster 를 사용할 수 있습니다 . 두 번째 요구 사항에서는 Amazon S3를 사용하여 콜드 데이터를 저장할 수 있습니다. Amazon S3는 Amazon S3 Glacier / Glacier Deep Archive를 통해 콜드 스토리지 시스템을 지원합니다.

따라서 정답은 Use Amazon FSx For Luster 및 Amazon S3 for hot and cold storage입니다 .

프로비저닝 된 IOPS SSD (io1) 볼륨이 I / O 집약적 워크로드의 요구를 충족하기 위해 핫 스토리지로 설계 되었기 때문에 Amazon FSx For Luster 및 Amazon EBS 프로비저닝 된 IOPS SSD (io1) 볼륨을 각각 핫 스토리지 및 콜드 스토리지에 사용하는 것은 올바르지 않습니다. EBS에는 Cold HDD라는 저장 옵션이 있지만 콜드 데이터를 저장하는 데 사용되지 않습니다. 또한 EBS Cold HDD는 Amazon S3 Glacier / Glacier Deep Archive를 사용하는 것보다 훨씬 비쌉니다.

EFS가 데이터에 대한 동시 액세스를 지원하지만 기계 학습 워크로드에 필요한 고성능 기능이 없기 때문에 Amazon Elastic File System과 Amazon S3를 각각 핫 스토리지 및 콜드 스토리지에 사용하는 것은 올바르지 않습니다.

Amazon FSx For Windows File Server 및 Amazon S3를 핫 스토리지 및 콜드 스토리지에 각각 사용하는 것은 Lustre와 달리 Amazon FSx For Windows File Server에 병렬 파일 시스템이 없기 때문에 올바르지 않습니다.

이 시나리오에서 현재 사용중인 EC2 인스턴스는 사전 구축 된 AMI에 따라 다릅니다. 이 AMI는 다른 리전에 액세스 할 수 없으므로 재해 복구 인스턴스를 올바르게 설정하려면 us-west-2 리전에 복사해야합니다.

작업을 지원하는 AWS Management Console, AWS 명령 줄 도구 또는 SDK 또는 Amazon EC2 API를 사용하여 AWS 리전 내부 또는 전체에서 Amazon 머신 이미지 (AMI)를 복사 할 수 있습니다 CopyImage . Amazon EBS 지원 AMI와 인스턴스 스토어 지원 AMI를 모두 복사 할 수 있습니다. 암호화 된 스냅 샷을 사용하여 암호화 된 AMI 및 AMI를 복사 할 수 있습니다.

'Server Infra > AWS' 카테고리의 다른 글

| AWS EBS Cold HDD sc1 관련 (0) | 2020.10.15 |

|---|---|

| AWS의 네트워크 인터페이스 (0) | 2020.10.15 |

| AWS DNA 1기 교육자료 정리 (0) | 2020.10.15 |

| AWS ECS Fargate 구조 (0) | 2020.09.29 |

| RDS MySQL과 Aurora MySQL의 차이점 (0) | 2020.09.24 |